درون یابی فریم فرآیند سنتز تصاویر بین یک مجموعه معین از تصاویر است. این تکنیک اغلب برای نمونه برداری موقت برای افزایش نرخ تازه سازی ویدیوها یا ایجاد جلوه های حرکت آهسته استفاده می شود. امروزه، با دوربین های دیجیتال و گوشی های هوشمند، ما اغلب چندین عکس را در عرض چند ثانیه می گیریم تا بهترین عکس را ثبت کنیم. درون یابی بین این عکسهای «تقریباً تکراری» میتواند منجر به ویدیوهای جذابی شود که حرکت صحنه را نشان میدهد و اغلب حس لذتبخشتری از لحظه را نسبت به عکسهای اصلی ارائه میدهد.

درون یابی فریم بین فریم های ویدیویی متوالی، که اغلب دارای حرکت کوچک هستند، به طور گسترده مورد مطالعه قرار گرفته است. با این حال، بر خلاف ویدیوها، فاصله زمانی بین عکسهای تقریباً تکراری میتواند چندین ثانیه باشد، با حرکت نسبتاً بزرگ در بین، که یک نقطه شکست اصلی روشهای درونیابی فریم موجود است. روشهای اخیر تلاش میکنند با آموزش روی مجموعه دادهها با حرکت شدید، هر چند با اثربخشی محدود در حرکات کوچکتر، حرکت بزرگ را مدیریت کنند.

در «FILM: Frame Interpolation for Large Motion» که در ECCV 2022 منتشر شد، روشی برای ایجاد ویدیوهای حرکت آهسته با کیفیت بالا از عکسهای تقریباً تکراری ارائه میکنیم. FILM یک معماری شبکه عصبی جدید است که نتایج پیشرفتهای را در حرکتهای بزرگ به دست میآورد، در حالی که حرکات کوچکتر را به خوبی مدیریت میکند.

|

| FILM بین دو عکس تقریباً تکراری برای ایجاد یک ویدیوی حرکت آهسته درون یابی می کند. |

بررسی اجمالی مدل FILM

مدل FILM دو تصویر را به عنوان ورودی می گیرد و یک تصویر میانی را خروجی می دهد. در زمان استنتاج، ما به صورت بازگشتی مدل را برای خروجی بین تصاویر فراخوانی می کنیم. FILM دارای سه جزء است: (1) یک استخراج کننده ویژگی که هر تصویر ورودی را با ویژگی های چند مقیاسی عمیق (هرمی) خلاصه می کند. (2) یک تخمینگر حرکت دو جهته که حرکت پیکسلی (یعنی جریانها) را در هر سطح هرم محاسبه میکند. و (3) یک ماژول فیوژن که تصویر درون یابی نهایی را خروجی می دهد. ما FILM را روی قابهای سهقلوی معمولی ویدیو آموزش میدهیم، که فریم میانی به عنوان حقیقت اصلی برای نظارت عمل میکند.

|

| یک ویژگی استاندارد استخراج هرم روی دو تصویر ورودی. ویژگیها در هر سطح توسط یک سری پیچیدگی پردازش میشوند، که سپس به نصف وضوح فضایی نمونهبرداری میشوند و به عنوان ورودی به سطح عمیقتر ارسال میشوند. |

استخراج ویژگی مقیاس-آگنوستیک

حرکت بزرگ معمولاً با تخمین حرکت سلسله مراتبی با استفاده از اهرام ویژگی چند وضوح (نشان داده شده در بالا) انجام می شود. با این حال، این روش با اجسام کوچک و با حرکت سریع مبارزه می کند زیرا آنها می توانند در عمیق ترین سطوح هرم ناپدید شوند. علاوه بر این، تعداد پیکسلهای موجود کمتری برای استخراج نظارت در عمیقترین سطح وجود دارد.

برای غلبه بر این محدودیتها، ما یک استخراجکننده ویژگی را اتخاذ میکنیم که وزنها را در مقیاسها به اشتراک میگذارد تا یک هرم ویژگی «مقیاس-آگنوستیک» ایجاد کند. این استخراج کننده ویژگی (1) با معادل سازی حرکت بزرگ در سطوح کم عمق با حرکت کوچک در سطوح عمیق تر، امکان استفاده از تخمینگر حرکت مشترک را در سطوح هرم (بخش بعدی) فراهم می کند و (2) یک شبکه فشرده با وزن کمتر ایجاد می کند.

به طور خاص، با توجه به دو تصویر ورودی، ابتدا یک هرم تصویر را با پایین آوردن متوالی هر تصویر ایجاد می کنیم. در مرحله بعد، از یک رمزگذار کانولوشنال U-Net مشترک برای استخراج یک هرم ویژگی کوچکتر از هر سطح هرم تصویر (ستونهای شکل زیر) استفاده میکنیم. به عنوان سومین و آخرین مرحله، ما یک هرم ویژگی مقیاس-آگنوستیک را با الحاق افقی ویژگیها از لایههای پیچیدگی مختلف که ابعاد فضایی یکسانی دارند، میسازیم. توجه داشته باشید که از سطح سوم به بعد، پشته ویژگی با همان مجموعه وزن های کانولوشن مشترک (نشان داده شده در همان رنگ) ساخته می شود. این تضمین میکند که همه ویژگیها مشابه هستند، که به ما امکان میدهد به اشتراک وزنها در تخمینگر حرکت بعدی ادامه دهیم. شکل زیر این فرآیند را با استفاده از چهار سطح هرمی نشان می دهد، اما در عمل از هفت استفاده می کنیم.

تخمین جریان دو جهته

پس از استخراج ویژگی، FILM تخمین جریان باقیمانده مبتنی بر هرم را برای محاسبه جریانها از تصویر میانی که هنوز پیشبینی نشده است به دو ورودی انجام میدهد. تخمین جریان یک بار برای هر ورودی انجام می شود که از عمیق ترین سطح شروع می شود و با استفاده از پشته ای از پیچش ها شروع می شود. ما جریان را در یک سطح معین با افزودن یک اصلاح باقیمانده به تخمین نمونهبرداری شده از سطح عمیقتر بعدی تخمین میزنیم. این رویکرد موارد زیر را به عنوان ورودی خود در نظر میگیرد: (1) ویژگیهای ورودی اول در آن سطح، و (2) ویژگیهای ورودی دوم پس از اینکه با تخمین نمونهسازی شده منحرف شد. وزنهای پیچشی یکسان در همه سطوح بهجز دو بهترین سطح مشترک است.

وزن های مشترک اجازه می دهد تا تفسیر حرکات کوچک در سطوح عمیق تر مانند حرکات بزرگ در سطوح کم عمق باشد و تعداد پیکسل های موجود برای نظارت بر حرکت بزرگ را افزایش می دهد. علاوه بر این، وزنهای مشترک نه تنها آموزش مدلهای قدرتمندی را که ممکن است به نسبت سیگنال به نویز بالاتری (PSNR) برسند را امکانپذیر میسازد، بلکه برای جا انداختن مدلها در حافظه GPU برای کاربردهای عملی نیز مورد نیاز است.

|

|

| تاثیر اشتراک وزن بر کیفیت تصویر ترک کرد: بدون اشتراک گذاری، درست: اشتراک گذاری برای این فرسایش ما از یک نسخه کوچکتر از مدل خود استفاده کردیم (که در مقاله FILM-med نامیده می شود) زیرا مدل کامل بدون اشتراک وزن از هم جدا می شود زیرا مزیت منظم سازی تقسیم وزن از بین می رود. |

Fusion و Frame Generation

هنگامی که جریان های دو جهته تخمین زده می شوند، دو هرم ویژگی را به هم تراز می کنیم. ما یک هرم ویژگی به هم پیوسته را با انباشتن دو نقشه ویژگی تراز شده، جریان های دو جهته و تصاویر ورودی در هر سطح هرم به دست می آوریم. در نهایت، یک رمزگشای U-Net تصویر خروجی درون یابی شده را از هرم ویژگی تراز و انباشته ترکیب می کند.

|

| معماری فیلم. استخراج ویژگی: ما ویژگی های مقیاس-آگنوستیک را استخراج می کنیم. ویژگی های با رنگ های منطبق با استفاده از وزن های مشترک استخراج می شوند. تخمین جریان: ما جریان های دو جهته را با استفاده از وزن های مشترک در سطوح عمیق تر هرم محاسبه می کنیم و ویژگی ها را به هم تراز می کنیم. ذوب: یک رمزگشا U-Net فریم درون یابی نهایی را خروجی می دهد. |

توابع از دست دادن

در طول آموزش، ما با ترکیب سه باخت بر FILM نظارت می کنیم. اول، ما از تفاوت L1 مطلق بین فریم های پیش بینی شده و واقعی برای ثبت حرکت بین تصاویر ورودی استفاده می کنیم. با این حال، هنگامی که به تنهایی استفاده می شود، تصاویری تار ایجاد می کند. دوم، از دست دادن ادراکی برای بهبود وفاداری تصویر استفاده می کنیم. این تفاوت L1 را بین ویژگی های از پیش آموزش دیده VGG-19 ImageNet استخراج شده از فریم های حقیقت پیش بینی شده و زمینی به حداقل می رساند. سوم، ما از Style loss برای به حداقل رساندن تفاوت L2 بین ماتریس Gram ویژگی های VGG-19 از پیش آموزش دیده ImageNet استفاده می کنیم. از دست دادن سبک شبکه را قادر می سازد تا تصاویر واضح و نقاشی های واقعی از مناطق بزرگ از پیش مسدود شده تولید کند. در نهایت، زیانها با وزنهایی که بهطور تجربی انتخاب شدهاند، ترکیب میشوند، به طوری که هر ضرر به طور مساوی در ضرر کل مشارکت دارد.

در زیر نشان داده شده است، از دست دادن ترکیبی تا حد زیادی وضوح و وفاداری تصویر را در مقایسه با آموزش FILM با اتلاف L1 و VGG بهبود می بخشد. از دست دادن ترکیبی، تیزی برگ های درخت را حفظ می کند.

|

| توابع از دست دادن ترکیبی FILM. باخت L1 (ترک کرد), L1 به علاوه کاهش VGG (وسط، و از دست دادن سبک (درست، بهبود قابل توجهی در وضوح (جعبه سبز) نشان می دهد. |

نتایج تصویر و ویدئو

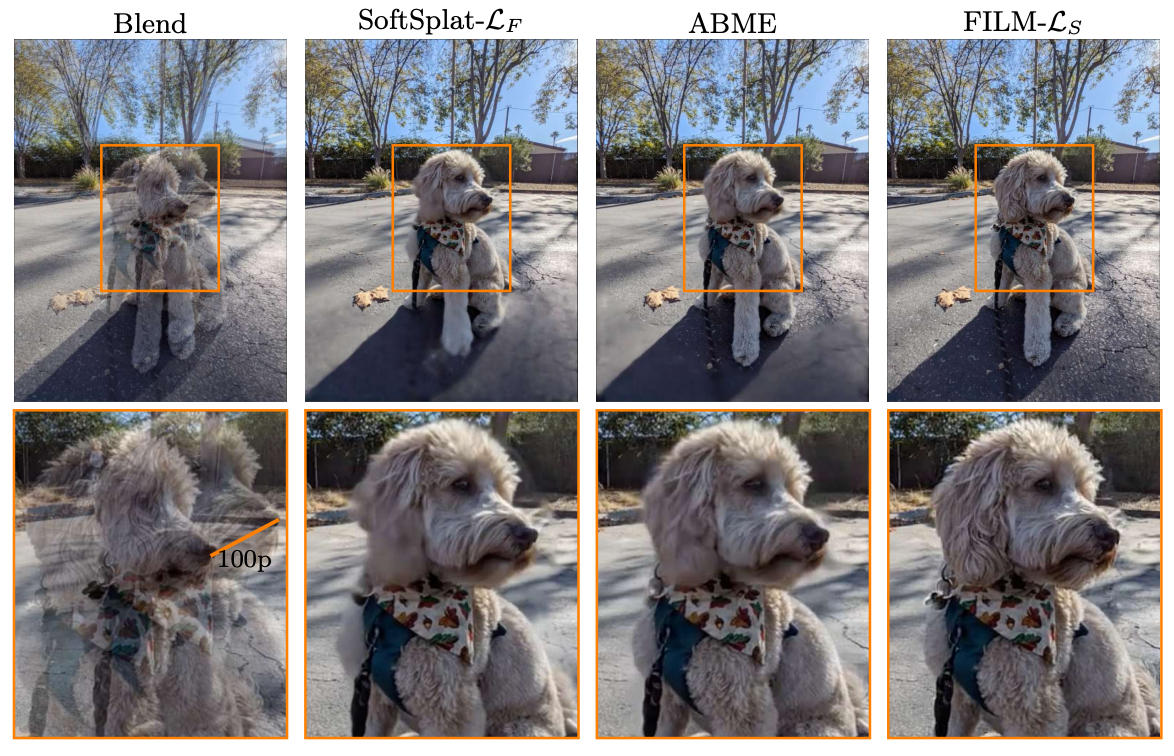

ما FILM را بر روی مجموعه داده های داخلی عکس های تقریبا تکراری ارزیابی می کنیم که حرکت صحنه بزرگ را نشان می دهد. علاوه بر این، ما FILM را با روش های درون یابی فریم اخیر مقایسه می کنیم: SoftSplat و ABME. FILM هنگام درونیابی در سراسر حرکت بزرگ عملکرد مطلوبی دارد. حتی در حضور حرکتی به بزرگی 100 پیکسل، FILM تصاویر واضحی مطابق با ورودی تولید می کند.

|

| درون یابی فریم با SoftSplat (ترک کردABME (وسط) و فیلم (درست) کیفیت تصویر مطلوب و ثبات زمانی را نشان می دهد. |

|

|

| درون یابی حرکتی بزرگ بالا: فیلم حرکت آهسته 64x. پایین (از چپ به راست): دو تصویر ورودی ترکیب شده اند، درون یابی SoftSplat، درون یابی ABME و درون یابی FILM. FILM با حفظ جزئیات پسزمینه، چهره سگ را میگیرد. |

نتیجه

ما FILM را معرفی می کنیم، یک شبکه عصبی درون یابی قاب حرکتی بزرگ. FILM در هسته خود از یک هرم ویژگی مقیاس-آگنوستیک استفاده میکند که وزنها را در بین مقیاسها به اشتراک میگذارد، که به ما امکان میدهد یک تخمینگر حرکت دو جهته «مقیاس-آگنوستیک» بسازیم که از فریمهایی با حرکت عادی یاد میگیرد و به خوبی به فریمهایی با حرکت بزرگ تعمیم میدهد. برای رسیدگی به انسدادهای گسترده ناشی از حرکت صحنه بزرگ، FILM را با تطبیق ماتریس Gram ویژگی های از پیش آموزش دیده VGG-19 ImageNet، که منجر به نقاشی واقعی و تصاویر واضح می شود، نظارت می کنیم. FILM در حرکات بزرگ عملکرد مطلوبی دارد، در حالی که حرکات کوچک و متوسط را نیز به خوبی مدیریت میکند، و فیلمهایی با کیفیت بالا برای مدت زمانی روان تولید میکند.

خودتان آن را امتحان کنید

میتوانید با استفاده از کدهای منبع، که اکنون به صورت عمومی در دسترس هستند، FILM را روی عکسهای خود امتحان کنید.

سپاسگزاریها

مایلیم از اریک تابلیون، دکینگ سان، کارولین پانتوفارو، برایان کورلس برای کمکهایشان تشکر کنیم. ما از مارک کومینو ترینیداد برای مشارکتهایش در استخراجکننده ویژگیهای آگنوستیک، اورلی لیبا و چارلز هرمان برای بازخورد درباره متن، جیمی آسپینال برای تصاویر در مقاله، دومینیک کایزر، ییل پریچ، مایکل نچیبا، ویلیام تی فریمن، تشکر میکنیم. دیوید سالسین، کاترین واه، و ایرا کمل ماخر-شلیزرمن برای حمایت.