تعامل ساده و مؤثر بین رباتهای انسانی و چهارپا راه را برای ایجاد رباتهای کمکی هوشمند و توانا هموار میکند و آیندهای را رقم میزند که در آن فناوری زندگی ما را فراتر از تصور ما افزایش میدهد. کلید چنین سیستم های تعامل انسان و ربات این است که ربات های چهارپا را قادر می سازد به دستورالعمل های زبان طبیعی پاسخ دهند. پیشرفتهای اخیر در مدلهای زبان بزرگ (LLM) پتانسیل اجرای برنامهریزی سطح بالا را نشان داده است. با این حال، درک دستورات سطح پایین، مانند اهداف زاویه مشترک یا گشتاور موتور، به ویژه برای رباتهای پایی که ذاتاً ناپایدار هستند، برای LLMها یک چالش باقی میماند که نیاز به سیگنالهای کنترل فرکانس بالا دارد. در نتیجه، بیشتر کارهای موجود، ارائه APIهای سطح بالا برای LLMها را برای دیکته کردن رفتار ربات فرض می کند، که ذاتاً قابلیت های بیانی سیستم را محدود می کند.

در «SayTap: زبان به حرکت چهارپا»، ما رویکردی را پیشنهاد میکنیم که از الگوهای تماس پا (که به ترتیب و روشی که یک عامل چهار پا هنگام حرکت پاهای خود را روی زمین قرار میدهد) بهعنوان رابطی برای پل زدن فرمانهای انسان استفاده میکند. به زبان طبیعی و یک کنترل کننده حرکت که دستورات سطح پایین را خروجی می دهد. این منجر به یک سیستم ربات چهارپا تعاملی می شود که به کاربران امکان می دهد به طور انعطاف پذیر رفتارهای حرکتی متنوعی را ایجاد کنند (به عنوان مثال، کاربر می تواند از ربات بخواهد راه برود، بدود، بپرد یا حرکات دیگری را با استفاده از زبان ساده انجام دهد). ما یک طراحی سریع LLM، یک تابع پاداش و روشی برای نمایش کنترلر SayTap در معرض توزیع امکان پذیر الگوهای تماس ارائه می دهیم. ما نشان میدهیم که SayTap کنترلکنندهای است که قادر به دستیابی به الگوهای حرکتی متنوعی است که میتواند به سختافزار ربات واقعی منتقل شود.

روش SayTap

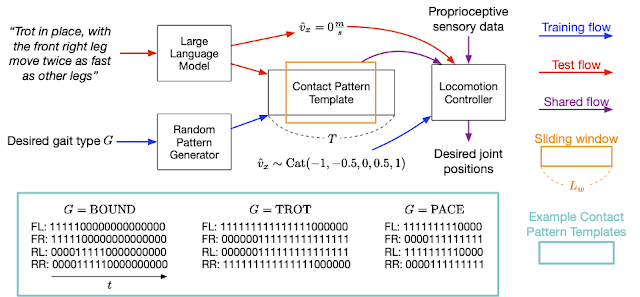

رویکرد SayTap از یک الگوی تماس استفاده میکند که 4 X است تی ماتریسی از 0s و 1s، با 0s نشان دهنده پاهای عامل در هوا و 1s برای پاهای روی زمین است. از بالا به پایین، هر ردیف در ماتریس، الگوهای تماس پاهای جلو چپ (FL)، جلو راست (FR)، عقب چپ (RL) و عقب راست (RR) را نشان می دهد. فرکانس کنترل SayTap 50 هرتز است، بنابراین هر 0 یا 1 0.02 ثانیه طول می کشد. در این کار، یک الگوی تماس پا مورد نظر توسط یک پنجره کشویی چرخه ای به اندازه L تعریف می شودw و به شکل 4 XLw. پنجره کشویی از الگوی الگوی تماس چهار پرچم تماس با زمین استخراج می کند که نشان می دهد پا روی زمین است یا در هوا بین تی + 1 و تی + الw. شکل زیر نمای کلی از روش SayTap را ارائه می دهد.

SayTap این الگوهای تماس پا مورد نظر را به عنوان یک رابط جدید بین دستورات کاربر زبان طبیعی و کنترل کننده حرکت معرفی می کند. از کنترل کننده حرکت برای تکمیل کار اصلی (مثلاً پیروی از سرعت های مشخص) و قرار دادن پای ربات روی زمین در زمان مشخص شده استفاده می شود، به گونه ای که الگوهای تماس پا تا حد امکان به الگوهای تماس مورد نظر نزدیک شوند. برای دستیابی به این هدف، کنترلکننده حرکت، الگوی تماس پا مورد نظر را در هر مرحله زمانی به عنوان ورودی خود، علاوه بر دادههای حسی حس عمقی ربات (به عنوان مثال، موقعیتها و سرعتهای مفاصل) و ورودیهای مربوط به کار (مانند دستورات سرعت مشخص شده توسط کاربر) میگیرد. . ما از یادگیری تقویت عمیق برای آموزش کنترل کننده حرکت و نمایش آن به عنوان یک شبکه عصبی عمیق استفاده می کنیم. در طول آموزش کنترلر، یک ژنراتور تصادفی از الگوهای تماس پا مورد نظر نمونه برداری می کند، سپس این خط مشی برای خروجی اقدامات سطح پایین ربات برای دستیابی به الگوی تماس پا مورد نظر بهینه می شود. سپس در زمان تست یک LLM دستورات کاربر را به الگوهای تماس پا ترجمه می کند.

|

| نمای کلی رویکرد SayTap. |

| SayTap از الگوهای تماس پا (به عنوان مثال، 0 و 1 دنباله برای هر پا در قسمت داخلی، که در آن 0s پا در هوا و 1s پا روی زمین است) به عنوان رابطی که دستورات کاربر زبان طبیعی و دستورات کنترل سطح پایین را پل می کند، استفاده می کند. SayTap با یک کنترلکننده حرکت مبتنی بر یادگیری تقویتی که برای تحقق الگوهای تماس مورد نظر آموزش دیده است، به یک ربات چهارپا اجازه میدهد دستورالعملهای ساده و مستقیم (مثلاً «به آهستگی به جلو حرکت کند») و همچنین دستورات کاربر مبهم (مثلاً « خبر خوب، آخر این هفته به پیک نیک می رویم!») و مطابق با آن واکنش نشان دهید. |

ما نشان میدهیم که LLM قادر است دستورات کاربر را به طور دقیق در قالبهای الگوی تماس پا در قالبهای مشخص نگاشت، در صورتی که به درستی طراحی شده باشد، حتی در مواردی که دستورات بدون ساختار یا مبهم هستند. در آموزش، از یک ژنراتور الگوی تصادفی برای تولید الگوهای الگوی تماسی با طولهای الگوی مختلف استفاده میکنیم تی، نسبت تماس پا به زمین در یک چرخه بر اساس نوع راه رفتن معین جی، به طوری که کنترل کننده حرکت در توزیع گسترده ای از حرکات که منجر به تعمیم بهتر می شود یاد بگیرد. برای جزئیات بیشتر به مقاله مراجعه کنید.

نتایج

با یک اعلان ساده که شامل تنها سه نمونه درون متنی از الگوهای تماس معمولی پا است، یک LLM میتواند دستورات انسانی مختلف را با دقت به الگوهای تماس ترجمه کند و حتی به مواردی تعمیم دهد که به صراحت نحوه واکنش ربات را مشخص نمیکند.

دستورات SayTap مختصر هستند و از چهار جزء تشکیل شده اند: (1) دستورالعمل کلی که وظایفی را که LLM باید انجام دهد را توصیف می کند. (2) تعریف راه رفتن که دانش پایه را در مورد راه رفتن چهارپا و نحوه ارتباط آنها با احساسات به LLM یادآوری می کند. (3) تعریف فرمت خروجی. و (4) مثال هایی که به LLM فرصت یادگیری درون زمینه ای می دهد. ما همچنین پنج سرعت را مشخص می کنیم که به یک ربات اجازه می دهد به جلو یا عقب، سریع یا آهسته حرکت کند یا ثابت بماند.

General instruction block You are a dog foot contact pattern expert. Your job is to give a velocity and a foot contact pattern based on the input. You will always give the output in the correct format no matter what the input is. Gait definition block The following are description about gaits: 1. Trotting is a gait where two diagonally opposite legs strike the ground at the same time. 2. Pacing is a gait where the two legs on the left/right side of the body strike the ground at the same time. 3. Bounding is a gait where the two front/rear legs strike the ground at the same time. It has a longer suspension phase where all feet are off the ground, for example, for at least 25% of the cycle length. This gait also gives a happy feeling. Output format definition block The following are rules for describing the velocity and foot contact patterns: 1. You should first output the velocity, then the foot contact pattern. 2. There are five velocities to choose from: [-1.0, -0.5, 0.0, 0.5, 1.0]. 3. A pattern has 4 lines, each of which represents the foot contact pattern of a leg. 4. Each line has a label. "FL" is front left leg, "FR" is front right leg, "RL" is rear left leg, and "RR" is rear right leg. 5. In each line, "0" represents foot in the air, "1" represents foot on the ground. Example block Input: Trot slowly Output: 0.5 FL: 11111111111111111000000000 FR: 00000000011111111111111111 RL: 00000000011111111111111111 RR: 11111111111111111000000000 Input: Bound in place Output: 0.0 FL: 11111111111100000000000000 FR: 11111111111100000000000000 RL: 00000011111111111100000000 RR: 00000011111111111100000000 Input: Pace backward fast Output: -1.0 FL: 11111111100001111111110000 FR: 00001111111110000111111111 RL: 11111111100001111111110000 RR: 00001111111110000111111111 Input:

| SayTap اعلان به LLM. متون به رنگ آبی برای تصویرسازی استفاده میشوند و به LLM وارد نمیشوند. |

پیروی از دستورات ساده و مستقیم

در ویدیوهای زیر نشان میدهیم که سیستم SayTap میتواند وظایفی را که دستورات مستقیم و واضح هستند با موفقیت انجام دهد. اگرچه برخی از دستورات توسط سه مثال درون متنی پوشش داده نمیشوند، ما میتوانیم LLM را راهنمایی کنیم تا دانش درونی خود را از مرحله پیشآموزشی از طریق «بلوک تعریف راه رفتن» (به بلوک دوم در اعلان ما در بالا نگاه کنید) بیان کند. اعلان

پیروی از دستورات بدون ساختار یا مبهم

اما آنچه جالب تر است، توانایی SayTap برای پردازش دستورالعمل های بدون ساختار و مبهم است. ربات تنها با یک اشاره کوچک در فرمان برای ارتباط برخی راه رفتن ها با برداشت های کلی از احساسات، هنگام شنیدن پیام های هیجان انگیز مانند “ما به پیک نیک می رویم!” علاوه بر این، صحنهها را بهطور دقیق نشان میدهد (مثلاً حرکت سریع در حالی که پاهایش به سختی زمین را لمس میکنند وقتی گفته میشود زمین بسیار داغ است).

نتیجه گیری و کار آینده

ما SayTap، یک سیستم تعاملی برای رباتهای چهارپا را ارائه میکنیم که به کاربران اجازه میدهد تا به طور انعطافپذیر رفتارهای حرکتی متنوعی را ایجاد کنند. SayTap الگوهای تماس پا مورد نظر را به عنوان یک رابط جدید بین زبان طبیعی و کنترل کننده سطح پایین معرفی می کند. این رابط جدید ساده و منعطف است، علاوه بر این، به یک ربات اجازه میدهد هم دستورالعملها و هم دستوراتی را دنبال کند که به صراحت بیان نمیکنند که ربات چگونه باید واکنش نشان دهد.

یک جهت جالب برای کار آینده این است که آزمایش کنید آیا دستوراتی که دلالت بر احساس خاصی دارند به LLM اجازه می دهد راه رفتن دلخواه را به دست آورد یا خیر. در بلوک تعریف راه رفتن نشان داده شده در بخش نتایج بالا، جملهای ارائه میکنیم که خلق و خوی شاد را با راه رفتنهای محدود پیوند میدهد. ما معتقدیم که ارائه اطلاعات بیشتر می تواند تفاسیر LLM (به عنوان مثال، احساسات ضمنی) را تقویت کند. در ارزیابی ما، ارتباط بین احساس شادی و راه رفتن محدود باعث شد تا ربات در هنگام پیروی از دستورات مبهم انسان به وضوح عمل کند. یکی دیگر از جهتگیریهای جالب برای کار آینده، معرفی ورودیهای چند وجهی، مانند ویدئو و صدا است. الگوهای تماس پا که از آن سیگنالها ترجمه شدهاند، در تئوری، همچنان با خط لوله ما کار میکنند و موارد استفاده جالبتری را باز میکنند.

سپاسگزاریها

Yujin Tang، Wenhao Yu، Jie Tan، Heiga Zen، Aleksandra Faust و Tatsuya Harada این تحقیق را انجام دادند. این کار زمانی طراحی و اجرا شد که تیم در Google Research بود و در Google DeepMind ادامه خواهد یافت. نویسندگان میخواهند از Tingnan Zhang، Linda Luu، Kuang-Huei Lee، Vincent Vanhoucke و Douglas Eck برای بحثهای ارزشمند و پشتیبانی فنی در آزمایشها تشکر کنند.