محققان این ایده را آزمایش کردند که یک مدل هوش مصنوعی ممکن است در تشخیص محتوای خود مزیتی داشته باشد، زیرا تشخیص از همان آموزش و مجموعه داده ها استفاده می کند. چیزی که آنها انتظار نداشتند پیدا کنند این بود که از بین سه مدل هوش مصنوعی که آزمایش کردند، محتوای تولید شده توسط یکی از آنها به قدری غیرقابل شناسایی بود که حتی هوش مصنوعی که آن را تولید می کرد نیز نمی توانست آن را تشخیص دهد.

این مطالعه توسط محققان دپارتمان علوم کامپیوتر، دانشکده مهندسی Lyle در دانشگاه متودیست جنوبی انجام شد.

تشخیص محتوای هوش مصنوعی

بسیاری از آشکارسازهای هوش مصنوعی برای جستجوی سیگنال های آشکار محتوای تولید شده توسط هوش مصنوعی آموزش دیده اند. به این سیگنال ها “مصنوعات” می گویند که به دلیل فناوری ترانسفورماتور زیربنایی تولید می شوند. اما سایر مصنوعات برای هر مدل پایه منحصر به فرد هستند (مدل زبان بزرگی که هوش مصنوعی بر اساس آن ساخته شده است).

این مصنوعات برای هر هوش مصنوعی منحصر به فرد هستند و از داده های آموزشی متمایز و تنظیم دقیقی که همیشه از یک مدل هوش مصنوعی به مدل دیگر متفاوت است ناشی می شوند.

محققان شواهدی را کشف کردند که نشان میدهد این منحصر به فرد بودن است که یک هوش مصنوعی را قادر میسازد تا موفقیت بیشتری در شناسایی محتوای خود داشته باشد، به طور قابل توجهی بهتر از تلاش برای شناسایی محتوای تولید شده توسط یک هوش مصنوعی متفاوت.

Bard شانس بیشتری برای شناسایی محتوای تولید شده توسط Bard و ChatGPT درصد موفقیت بالاتری در شناسایی محتوای تولید شده توسط ChatGPT دارد، اما…

محققان دریافتند که این موضوع در مورد محتوای تولید شده توسط کلود صادق نیست. کلود در تشخیص محتوایی که تولید می کرد مشکل داشت. محققان ایده ای را در مورد اینکه چرا کلود قادر به تشخیص محتوای خود نبود به اشتراک گذاشتند و این مقاله در ادامه به آن می پردازد.

این ایده در پشت آزمون های تحقیق است:

از آنجایی که هر مدلی را می توان به طور متفاوت آموزش داد، ایجاد یک ابزار آشکارساز برای تشخیص مصنوعات ایجاد شده توسط همه ابزارهای مولد هوش مصنوعی ممکن دشوار است.

در اینجا، ما یک رویکرد متفاوت به نام خود تشخیصی را توسعه میدهیم، که در آن از خود مدل تولیدی برای تشخیص مصنوعات خود استفاده میکنیم تا متن تولید شده خود را از متن نوشته شده انسان متمایز کنیم.

این مزیت را دارد که ما نیازی به یادگیری تشخیص همه مدلهای هوش مصنوعی مولد نداریم، اما برای شناسایی فقط به یک مدل هوش مصنوعی مولد دسترسی داریم.

این یک مزیت بزرگ در دنیایی است که در آن مدلهای جدید به طور مداوم توسعه و آموزش داده میشوند.»

روش شناسی

محققان سه مدل هوش مصنوعی را آزمایش کردند:

- ChatGPT-3.5 توسط OpenAI

- بارد توسط گوگل

- کلود توسط آنتروپیک

تمام مدل های استفاده شده نسخه های سپتامبر 2023 بودند.

مجموعه داده ای از پنجاه موضوع مختلف ایجاد شد. به هر مدل هوش مصنوعی دقیقاً همان دستور داده شد تا مقالاتی با حدود 250 کلمه برای هر یک از پنجاه موضوع ایجاد کند که پنجاه مقاله برای هر سه مدل هوش مصنوعی ایجاد کرد.

سپس از هر مدل هوش مصنوعی خواسته شد تا محتوای خود را بازنویسی کند و یک مقاله اضافی تولید کند که بازنویسی هر مقاله اصلی بود.

آنها همچنین پنجاه مقاله تولید شده توسط انسان در مورد هر یک از پنجاه موضوع جمع آوری کردند. تمام مقالات تولید شده توسط انسان از BBC انتخاب شده است.

محققان سپس از دستور صفر شات برای تشخیص خود محتوای تولید شده توسط هوش مصنوعی استفاده کردند.

اعلان صفر یک نوع درخواست است که به توانایی مدلهای هوش مصنوعی برای انجام کارهایی که برای انجام آنها به طور خاص آموزش ندیدهاند متکی است.

محققان روش خود را بیشتر توضیح دادند:

ما یک نمونه جدید از هر سیستم هوش مصنوعی ایجاد کردیم که با یک پرس و جوی خاص شروع و مطرح شد: اگر متن زیر با الگوی نوشتاری و انتخاب کلمات مطابقت دارد. روال این است

برای مقالات اصلی، بازنویسی شده و انسانی تکرار می شود و نتایج ثبت می شود.ما همچنین نتیجه ابزار تشخیص هوش مصنوعی ZeroGPT را اضافه کردیم. ما از این نتیجه برای مقایسه عملکرد استفاده نمیکنیم، بلکه بهعنوان مبنایی برای نشان دادن چالشبرانگیز بودن کار شناسایی استفاده میکنیم.»

آنها همچنین خاطرنشان کردند که نرخ دقت 50٪ برابر با حدس زدن است که می تواند اساساً به عنوان سطحی از دقت در نظر گرفته شود که یک شکست است.

نتایج: خود تشخیصی

لازم به ذکر است که محققان اذعان داشتند که میزان نمونه گیری آنها پایین بوده و ادعا می کنند که نتایج قطعی است.

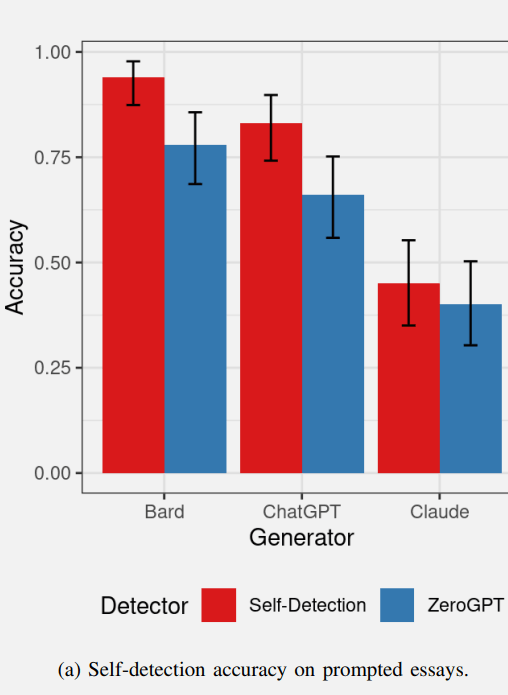

در زیر نموداری وجود دارد که میزان موفقیت خودشناسی هوش مصنوعی اولین دسته از مقالات را نشان می دهد. مقادیر قرمز نشان دهنده تشخیص خود هوش مصنوعی و آبی نشان دهنده عملکرد ZeroGPT ابزار تشخیص هوش مصنوعی است.

نتایج تشخیص خود هوش مصنوعی محتوای متنی خود

Bard در تشخیص محتوای خود نسبتاً خوب عمل کرد و ChatGPT نیز در تشخیص محتوای خود عملکرد مشابهی داشت.

ZeroGPT، ابزار تشخیص هوش مصنوعی محتوای Bard را به خوبی تشخیص داد و در تشخیص محتوای ChatGPT کمی بهتر عمل کرد.

ZeroGPT اساساً نتوانست محتوای تولید شده توسط کلود را شناسایی کند و عملکردی بدتر از آستانه 50٪ داشت.

کلود از گروه دورتر بود زیرا قادر به تشخیص محتوای خود نبود و عملکرد بسیار بدتری نسبت به Bard و ChatGPT داشت.

محققان این فرضیه را مطرح کردند که ممکن است خروجی کلود حاوی مصنوعات کمتر قابل تشخیص باشد، و توضیح می دهد که چرا کلود و ZeroGPT قادر به تشخیص مقالات کلود به عنوان تولید شده توسط هوش مصنوعی نیستند.

بنابراین، اگرچه کلود قادر به تشخیص قابل اعتماد محتوای خود نبود، اما این نشانه آن بود که خروجی کلود از نظر تولید مصنوعات هوش مصنوعی کمتر از کیفیت بالاتری برخوردار است.

ZeroGPT در تشخیص محتوای تولید شده توسط Bard بهتر از تشخیص محتوای ChatGPT و Claude عمل کرد. محققان فرض کردند که ممکن است بارد مصنوعات قابل تشخیص بیشتری تولید کند و تشخیص بارد را آسانتر کند.

بنابراین از نظر محتوای خودآشکار، بارد ممکن است مصنوعات قابل تشخیص بیشتری تولید کند و کلود مصنوعات کمتری تولید می کند.

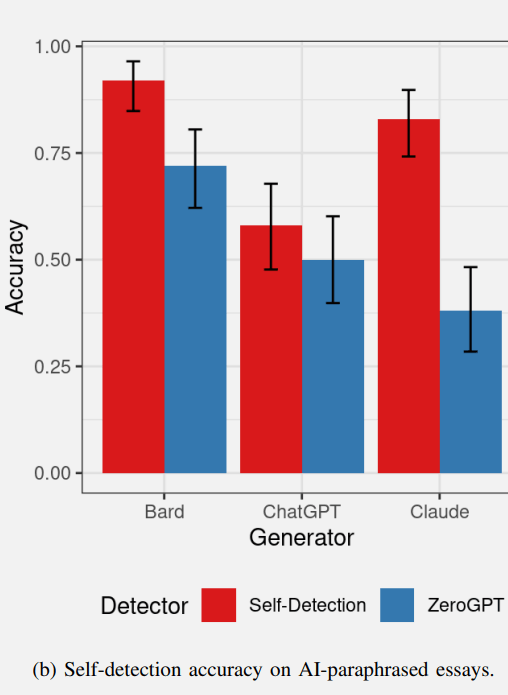

نتایج: محتوای بازنویسی شده خود تشخیص

محققان این فرضیه را مطرح کردند که مدلهای هوش مصنوعی میتوانند متن بازنویسی شدهشان را بهطور خودکار تشخیص دهند، زیرا مصنوعاتی که توسط مدل ایجاد میشوند (همانطور که در مقالههای اصلی شناسایی شدهاند) باید در متن بازنویسی شده نیز وجود داشته باشند.

با این حال، محققان اذعان کردند که درخواستهای نوشتن متن و بازنویسی متفاوت است، زیرا هر بازنویسی متفاوت از متن اصلی است که در نتیجه میتواند منجر به نتایج خودتشخیص متفاوتی برای تشخیص خود متن بازنویسی شود.

نتایج خودتشخیص متن بازنویسی شده در واقع با خود تشخیصی تست انشا اصلی متفاوت بود.

- بارد توانست محتوای بازنویسی شده را با سرعتی مشابه تشخیص دهد.

- ChatGPT قادر به تشخیص خود محتوای بازنویسی شده با نرخ بسیار بالاتر از نرخ 50٪ (که برابر با حدس زدن است) نبود.

- عملکرد ZeroGPT مشابه نتایج آزمایش قبلی بود و کمی بدتر عمل کرد.

شاید جالب ترین نتیجه را کلود آنتروپیک به دست آورد.

کلود قادر به تشخیص محتوای بازنویسی شده بود (اما در آزمون قبلی قادر به تشخیص مقاله اصلی نبود).

این یک نتیجه جالب است که مقالات اصلی کلود ظاهراً دارای مصنوعات کمی بود که نشان دهد هوش مصنوعی تولید شده است که حتی کلود نیز قادر به تشخیص آن نبود.

با این حال میتوانست بهطور خودکار این عبارت را تشخیص دهد در حالی که ZeroGPT نمیتوانست.

محققان در مورد این آزمون اظهار داشتند:

«این یافته که بازنویسی از ChatGPT جلوگیری میکند و در عین حال توانایی کلود در تشخیص خود را افزایش میدهد، بسیار جالب است و ممکن است نتیجه عملکرد درونی این دو مدل ترانسفورماتور باشد.»

تصویری از خودتشخیص محتوای بازنویسی شده با هوش مصنوعی

این آزمایشها نتایج تقریباً غیرقابلپیشبینی را به همراه داشت، بهویژه در مورد Anthropic’s Claude و این روند با آزمایش اینکه مدلهای هوش مصنوعی چقدر محتوای یکدیگر را تشخیص میدادند ادامه پیدا کرد، که چین و چروک جالبی داشت.

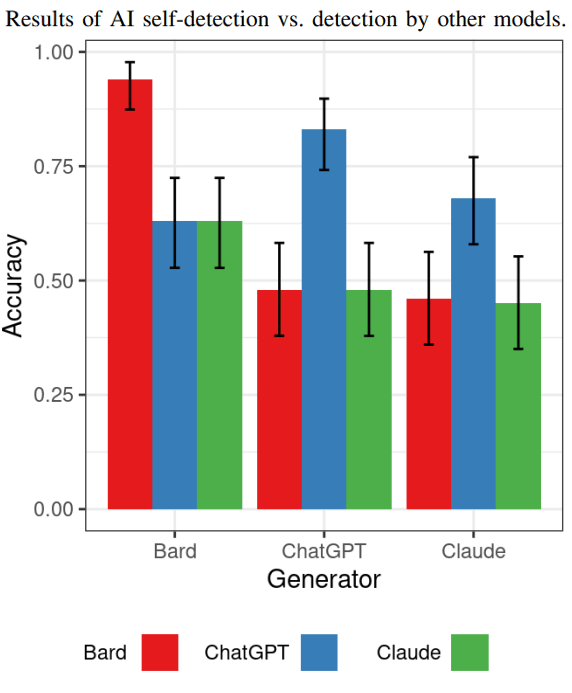

نتایج: مدلهای هوش مصنوعی محتوای یکدیگر را تشخیص میدهند

آزمایش بعدی نشان داد که هر مدل هوش مصنوعی در تشخیص محتوای تولید شده توسط سایر مدلهای هوش مصنوعی چقدر خوب عمل میکند.

اگر این درست باشد که بارد مصنوعات بیشتری نسبت به مدلهای دیگر تولید میکند، آیا مدلهای دیگر میتوانند محتوای تولید شده توسط بارد را به راحتی تشخیص دهند؟

نتایج نشان میدهد که بله، محتوای تولید شده توسط بارد سادهترین روش شناسایی توسط سایر مدلهای هوش مصنوعی است.

با توجه به شناسایی محتوای تولید شده ChatGPT، هم کلود و هم بارد قادر به تشخیص آن به عنوان تولید شده توسط هوش مصنوعی نبودند (همانطور که کلود قادر به تشخیص آن نبود).

ChatGPT توانست محتوای تولید شده توسط کلود را با سرعت بالاتری نسبت به Bard و Claude تشخیص دهد، اما این نرخ بالاتر خیلی بهتر از حدس زدن نبود.

یافتهها در اینجا این است که همه آنها در تشخیص محتوای یکدیگر چندان خوب نبودند، که به عقیده محققان ممکن است نشان دهد که تشخیص خود یک حوزه مطالعه امیدوارکننده است.

در اینجا نموداری است که نتایج این آزمایش خاص را نشان می دهد:

در این مرحله باید توجه داشت که محققان ادعا نمی کنند که این نتایج در مورد تشخیص هوش مصنوعی به طور کلی قطعی است. تمرکز این تحقیق آزمایشی بود تا ببینیم آیا مدلهای هوش مصنوعی میتوانند در تشخیص خود محتوای تولید شده خود موفق شوند یا خیر. پاسخ اکثراً بله است، آنها کار خود را بهتر انجام می دهند، اما نتایج مشابه آنچه در ZEROGpt یافت شد.

محققان اظهار نظر کردند:

«خودتشخیصی قدرت تشخیص مشابهی را در مقایسه با ZeroGPT نشان میدهد، اما توجه داشته باشید که هدف این مطالعه این نیست که ادعا کنیم تشخیص خود نسبت به روشهای دیگر برتری دارد، که برای مقایسه با بسیاری از روشهای پیشرفته نیاز به یک مطالعه بزرگ دارد. ابزارهای تشخیص محتوای هوش مصنوعی هنری در اینجا، ما فقط توانایی اولیه مدلها در تشخیص خود را بررسی میکنیم.»

نتیجه گیری و نکات مهم

نتایج آزمایش تایید می کند که تشخیص محتوای تولید شده توسط هوش مصنوعی کار آسانی نیست. Bard قادر به تشخیص محتوای خود و محتوای بازنویسی شده است.

ChatGPT میتواند محتوای خودش را شناسایی کند، اما روی محتوای بازنویسی شدهاش کمتر کار میکند.

کلود برجسته است زیرا قادر به تشخیص قابل اعتماد محتوای خود نیست، اما می تواند محتوای بازنویسی شده را تشخیص دهد که به نوعی عجیب و غیرمنتظره بود.

شناسایی مقالات اصلی کلود و مقالات بازنویسی شده برای ZeroGPT و سایر مدلهای هوش مصنوعی یک چالش بود.

محققان در مورد نتایج کلود خاطرنشان کردند:

“این نتیجه به ظاهر غیرقطعی نیاز به بررسی بیشتری دارد زیرا ناشی از دو دلیل درهم آمیخته است.

1) توانایی مدل برای ایجاد متن با مصنوعات بسیار کمی قابل تشخیص. از آنجایی که هدف این سیستم ها تولید متنی شبیه به انسان است، تعداد کمتر مصنوعاتی که تشخیص آنها سخت تر است به این معنی است که مدل به آن هدف نزدیک می شود.

2) توانایی ذاتی مدل در تشخیص خود را می توان تحت تأثیر معماری استفاده شده، دستور سریع و تنظیم دقیق اعمال شده قرار داد.

محققان این مشاهدات بیشتر در مورد کلود داشتند:

«فقط کلود را نمی توان شناسایی کرد. این نشان می دهد که کلود ممکن است مصنوعات قابل تشخیص کمتری نسبت به مدل های دیگر تولید کند.

نرخ تشخیص خودیابی از همین روند پیروی میکند و نشان میدهد که کلود متنی با مصنوعات کمتری ایجاد میکند و تشخیص آن را از نوشتههای انسانی سختتر میکند.

اما البته، بخش عجیب این است که کلود همچنین قادر به تشخیص محتوای اصلی خود نبود، برخلاف دو مدل دیگر که میزان موفقیت بالاتری داشتند.

محققان نشان دادند که خود تشخیصی یک حوزه جالب برای ادامه تحقیقات باقی مانده است و پیشنهاد کردند که مطالعات بیشتر می تواند بر مجموعه داده های بزرگتر با تنوع بیشتر متن تولید شده توسط هوش مصنوعی تمرکز کند، مدل های هوش مصنوعی اضافی را آزمایش کند، و در نهایت آنها مطالعه را پیشنهاد کردند. چگونه مهندسی سریع ممکن است بر سطوح تشخیص تأثیر بگذارد.

اصل مقاله پژوهشی و چکیده را اینجا بخوانید:

خود تشخیص محتوای هوش مصنوعی برای مدلهای زبان بزرگ مبتنی بر ترانسفورماتور

تصویر ویژه توسط Shutterstock/SObeR 9426