این یک نقطه روشن در یک بهروزرسانی بازار ناامیدکننده برای سرورهای مرکز داده بود که اوایل این ماه توسط Omdia تهیه شد: در حالی که بازوی تحقیقاتی Informa Tech پیشبینی ارسال سرور جهانی خود را برای سال 2023 برای دومین بار در سال جاری به 11 درصد کاهش داد. کاهش بیش از یک سال، شاهد رشد بی سابقه ای در استقرار خنک کننده مایع بوده است.

ولاد گالبوف، مدیر عملیات تحقیقاتی مرکز داده و ابری Omdia در زمان انتشار گزارش، با استناد به ارقام ارائه شده توسط فروشندگان تجهیزات مدیریت حرارتی، گزارش داد: «نقاط داده های اولیه تجهیزات خنک کننده مرکز داده نشان دهنده افزایش شدید در استقرار خنک کننده مایع است. برخی از فروشندگان که قبلاً افزایش فروش تجهیزات حرارتی را تا 20 برابر گزارش کرده بودند (این یک اشتباه تایپی نیست) در نیمه دوم سال گذشته، شاهد افزایش مداوم بیش از 50 درصدی در نیمه اول سال 2023 بودند.

به نظر می رسد داده های Omdia با تجزیه و تحلیل نظرسنجی سالانه ماه گذشته موسسه Uptime در تضاد باشد. Uptime از کاهش علاقه مدیران و طراحان تاسیسات به استفاده از خنک کننده مایع، حداقل در مقیاس قابل توجه، در کوتاه مدت صحبت می کند.

به گفته گالبوف و همکارش در Omdia، Manoj Sukumaran، تحلیلگر اصلی مرکز داده محاسبات و شبکه، یک موضوع مشترک وجود دارد که هر دو مشاهدات را توضیح می دهد. در یادداشت های جداگانه به دانش مرکز دادهگالبوف و سوکوماران به ما گفتند که اپراتورها و سازندگان مراکز داده (به استثنای ابر مقیاسکنندههای خاص، به اندازه کافی عجیب) سرمایهگذاریهای خود را بر روی تجهیزات با تراکم بالاتری متمرکز کردهاند که برای بار کاری هوش مصنوعی در نظر گرفته شدهاند. اینها دقیقاً همان کلاس سرورهایی هستند که باید کاندیدای انتخابی برای استقرار خنک کننده مایع باشند.

دوشاخه شدن

در اینجا پدیده در حال ظهور است: این سرورهای با چگالی بالاتر به طور طبیعی گران تر هستند، که افزایش متوسط قیمت واحد (AUP) را برای سرورهای ارسال شده توضیح می دهد. اما اپراتورها به تعداد زیادی از آنها نیاز ندارند (البته، زیرا آنها واحدهای با تراکم بالا هستند)، که همین موضوع باعث کاهش تعداد محموله ها می شود. با این حال، با توجه به اینکه این واحدهای جدید احتمالاً به حجم کاری هوش مصنوعی اختصاص داده می شوند، سرمایه گذاری اپراتورها در خنک کننده مایع می تواند به این زیرسیستم های هوش مصنوعی محدود شود. و این افزایش تقاضا برای سیستم های خنک کننده هوا محور با راندمان بالاتر را توضیح می دهد.

در خلاصه گزارش Galabov آمده است: «دانسیته توان رکهایی که محاسبات و ذخیرهسازی عمومی را در مراکز داده ارائهدهندگان خدمات ابری انجام میدهند 10 تا 20 کیلووات است. در مقایسه، چگالی توان قفسههایی که آموزش مدل هوش مصنوعی را محاسبه میکنند همیشه بیش از 20 کیلووات است.

ممکن است فکر کنید این اتفاقی است که هایپراسکیلرز قبلاً برای آن برنامه ریزی کرده اند. به گفته سوکوماران، همانطور که مشخص است، متا، مالک و اپراتور فیس بوک، امکاناتی را اجرا می کند که برای خنک کننده مایع بهینه نشده بودند. در نتیجه بهترین متا خنک کننده مایع با کمک هوا (AALC) است. AALC که با همکاری مایکروسافت توسعه یافته است مفهومی است که مهندسان متا از قبل از همهگیری کووید-19 به عنوان یک نوآوری که میتواند قابلیتهای خنککننده هوا را در تجهیزات معمولیتر گسترش دهد، تبلیغ میکردند.

یک جت کول SmartPlate مایع سرد را مستقیماً به سطح CPU می رساند. فریم از یک ویدیوی عمومی توسط JetCool.

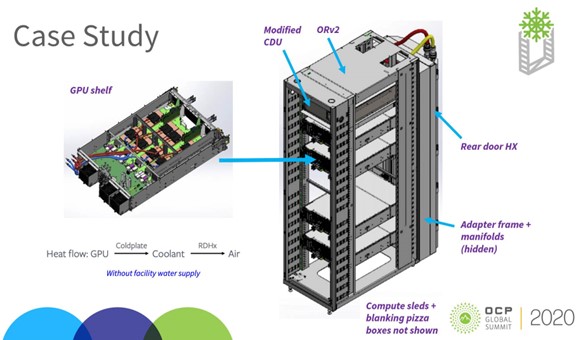

اولین بار در سال 2020 نشان داده شد، AALC شامل ارائه خنک کننده مایع حلقه بسته در قفسه های خنک شونده با هوا است. در اینجا، مسیر مایع با صفحات سرد متصل به پردازندهها (در آزمایشهای اولیه، به پردازندههای گرافیکی) شروع میشود، از طریق منیفولدهای سطح رک، به یک مبدل حرارتی درب عقب (HX) و یک واحد توزیع خنککننده اصلاحشده (CDU) ادامه مییابد. گرمای جذب شده توسط صفحات سرد از طریق HX و سپس از طریق جریان هوای خروجی موجود تخلیه می شود.

این یک ضمیمه خنک کننده مایع است، مطمئناً که به عنوان یک جزء خنک کننده مستقیم مایع (DLC) برای اهداف تولید واجد شرایط است. اما محصول نهایی، پس از نصب، رسما یک قفسه هوا خنک است. این توضیح می دهد که چرا استقرار DLC می تواند رشد کند، در حالی که امکانات خنک کننده هوا تقریباً به همان شکلی که هستند باقی می مانند.

سوکوماران گفت در حالی که امکانات متا برای AALC تجهیز شده است دانش مرکز داده، “به اندازه دمیدن هوای سرد از بیرون برای خنک کردن سرورها کارآمد نیست. انرژی اضافی مورد نیاز برای CDU و فن های بزرگ، مصرف برق غیر IT را اندکی افزایش می دهد و PUE را تحت تاثیر قرار می دهد.”

هنگامی که صورت و مخرج هر دو پایین می آیند

زمانی که معیار اثربخشی مصرف انرژی (PUE) ایجاد شد، به نظر می رسید که روشی معقول برای سنجش میزان مصرف انرژی کلی مرکز داده توسط تجهیزات نگهداری فناوری اطلاعات باشد. اما همانطور که سازنده تجهیزات Vertiv اخیراً اشاره کرد، یک راه حل خنک کننده واقعاً نوآورانه هم مصرف برق تجهیزات فناوری اطلاعات و هم مصرف برق کلی را کاهش می دهد – به ترتیب مخرج و شمارش در نسبت PUE. بنابراین کاملاً ممکن است که تأثیر یک نوآوری بزرگ در خنک کننده و قدرت توسط PUE کاملاً غیرقابل تشخیص باشد.

این پدیدهای را توضیح میدهد که هم Uptime و هم Omdia دیدهاند: روند PUE از زمان همهگیری ثابت مانده است. از قضا، زمانی که PUE سقوط نمیکند، همان نوآوریهای اصلی برای بازاریابی مؤثر دشوارتر میشوند. (هرگز اهمیتی نداشته باشید که چند بار PUE مرده اعلام شده است.)

گالبوف از Omdia گفت: “من فکر می کنم سطوح PUE در حال حاضر راکد شده است.” دانش مرکز داده، “و من اقدام گسترده ای را برای تغییر آنها نمی بینم.”

دانیل بیزو، مدیر تحقیقات اطلاعاتی Uptime، گفت دانش مرکز داده تقریباً از هر پنج مرکز، یک واحد درجاتی از خنککننده مایع را در قفسههای خود به کار میگیرد، و اکثریت انتظار دارند ظرف پنج سال از DLC استفاده کنند. با این حال، اینکه اکثر رک های مجهز به DLC رسماً به عنوان هوا خنک طبقه بندی می شوند یا خیر، به عواملی بستگی دارد که ممکن است هنوز پیش بینی نکرده باشیم. در حالی که این موضوع در حال حل شدن است، خنک کننده مایع همچنان انتخاب غالب کمتر از 10 درصد از اپراتورهایی است که Uptime بررسی کرده است.

Bizo گفت: “در حالت تعادل، Uptime شاهد ادامه جذب تدریجی DLC در چرخه های بازار در سال های آینده است.” قویترین محرکها، افزایش حجم کاری با الزامات محاسباتی متراکم، و به طور فزایندهای حوزههای درهم تنیده بهینهسازی هزینه، بهرهوری انرژی، و اعتبار پایداری است.

“داده های ما نشان می دهد که رک های با چگالی بسیار بالا (30 تا 40 کیلووات و بالاتر) در واقع رایج تر می شوند، اما استثنا باقی می مانند. توسعه AI و حجم های کاری مبتنی بر هوش مصنوعی احتمالا به شیوع رک های با چگالی بالا می افزایند. علاوه بر تاسیسات موجود برای محاسبات فنی مانند شبیه سازی های مهندسی، مشکلات بزرگ بهینه سازی و تجزیه و تحلیل داده های بزرگ.”

Sukumaran شرکت Omdia هشدار می دهد که هوش مصنوعی ممکن است روند تراکم را در جهت مخالف هدایت کند، به خصوص اگر زیرسیستم های هوش مصنوعی تسهیلات بیشتری به طور رسمی با هوا خنک شوند. Sukumaran گفت: “ما همچنین شاهد کاهش تراکم رک ها به دلیل مصرف انرژی بالای سرورهای مبتنی بر GPU و CPU هستیم.” بنابراین میتواند باد دمی برای فضای بیشتر و ظرفیت انرژی باشد.»

به ثبات رسیدن

ماه گذشته، HPE و اینتل مشارکت مشترک خود را در یک استاندارد شاسی و رک اعلام کردند که ادعا میکنند عمر مفید تجهیزات خنککننده هوا را افزایش میدهد. واحد سرور Cray XD220v HPE حدود یک اینچ و یک سوم عریض تر از ProLiant XD220n است و 4 آن را فعال می کند.هفتمپردازندههای نسل اینتل به هیت سینکهای گستردهتر یا صفحات سرد گستردهتر مجهز میشوند. با توجه به ترس اپراتورهایی که هنوز نگران مقابله با سیالات دی الکتریک هر روز هستند، سازندگان این ادعا را مطرح کردند که عملکرد XD220v زمانی که خنک کننده اختیاری DLC جایگزین خنک کننده هوای معمولی شد، فقط اندکی (به طور متوسط 1.8٪) افزایش یافت.

البته، DLC هرگز در مورد بهبود عملکرد پردازنده نبوده است – فقط هزینه آن. یک کلیک ساده بر روی نمودارهای HPE نشان می دهد که DLC واقعاً XD220v را بهبود بخشیده است عملکرد بر وات تقریباً 20٪ در باتری های آزمایشی SPECrate، SPEChpc و Linpack استاندارد صنعتی.

با این حال، واضح است که تیمهای بازاریابی تولیدکنندگان چه پیامی را در اینجا برجسته کردند: اگر تصمیم بگیرید سرمایهگذاریهای خنککننده مایع خود را برای پنج سال دیگر به تعویق بیندازید، برای شما خیلی بد نخواهد بود.

در همین حال، JetCool Technologies سازنده تجهیزات حرارتی آخرین فناوری DLC خود را که با همکاری DuPont توسعه یافته است، تبلیغ می کند. سیستم های SmartPlate و SmartLid آن متشکل از صفحات سرد هستند که مایع سرد را مستقیماً به سطح پردازنده ها می رسانند، از طریق آنچه JetCool توصیف می کند. ریزهمرفت کانال ها

با استناد به دادههای Uptime که نشان میدهد هزینههای بهبود زیرساخت عامل بازدارنده اولیه در اپراتورهایی است که تصمیم میگیرند خنککننده مایع همهجانبه را اتخاذ کنند، کاغذ سفید اخیر JetCool که با همکاری دل تهیه شده است، استدلال میکند که مراکز داده به اندازه کافی نگران هستند بدون اینکه سیل را در فهرست نگرانیهای خود قرار دهند.

JetCool میگوید: «با یک واحد مستقل، نیاز به ارتقاء زیرساختهای گسترده حذف میشود. فقدان سیستمهای لولهکشی و لولهکشی پیچیده همچنین خطر نشت یا خرابی سیستم را به حداقل میرساند، به طور بالقوه هزینههای تعمیر و جایگزینی را کاهش میدهد و حاوی نشتهای احتمالی در سطح سرور، نه در سطح رک یا تأسیسات است.

این یک پیام بازاریابی است که به نظر می رسد نه تنها برای نیازهای فوری مشتریانش تنظیم شده است، بلکه همچنین تمایلی به اذعان به چنین نیازهایی ندارند. DLC را امتحان کنید، تماس برای اقدام ادامه دارد. احتمالا کمک خواهد کرد. و اگر اینطور نباشد، چه آسیبی می تواند داشته باشد؟ اگر هنوز مجبور نیستید، بهتر از این است که تمام امکانات خود را با لوله های جریان سیال مجهز کنید.

Bizo از Uptime گفت: “تغییر عمده در DLC مملو از اصطکاک فنی و تجاری است.” دانش مرکز داده، “عمدتاً به دلیل فقدان استانداردها و رابط سازمانی از هم گسیخته بین مدیریت تاسیسات و تیم های فناوری اطلاعات. خنک کننده هوا عملکرد، ریسک و انتظارات هزینه اپراتورها را برآورده می کند (حتی اگر انرژی را هدر دهد) برای بیشتر موارد استفاده – و این شامل آخرین قدرت می شود. تراشه های گرسنه از Intel، AMD و Nvidia.”

علاوه بر این، Bizo ادامه داد، سطوح استفاده فنی از اکثر مراکز داده امروزه پایین است. فضای زیادی برای فناوری اطلاعات بیشتر وجود دارد – به همین دلیل است که سرمایهگذاری در سرورهای آماده هوش مصنوعی در بحبوحه کاهش کلی هزینههای مربوط به سرور در حال افزایش است. بنابراین نیازی فوری به افزایش تراکم سرور وجود ندارد. در نتیجه، Uptime درک میکند، “پذیرش DLC در بازار به طور یکنواخت پخش نمیشود و سیگنالهای تقاضا مخلوط میشوند.”

بیزو خاطرنشان کرد: «پیشبینیهای جاهطلبانه از تغییر فناوری در مراکز داده، تمایل به ناامیدی دارند.»

یادداشت ویراستار: هم Omdia و هم Data Center Knowledge بخشی از Informa Tech هستند.