چهارشنبه، 10 می، روز هیجان انگیزی برای جامعه تحقیقاتی گوگل بود، زیرا ما شاهد اعلام نتایج ماه ها و سال ها کار اساسی و کاربردی خود در مرحله Google I/O بودیم. با سرعت سریع اعلامیهها روی صحنه، انتقال تلاشهای اساسی و نوآوریهای منحصربهفرد که زیربنای فناوریهایی است که ارائه کردیم دشوار است. بنابراین امروز، ما هیجانزده هستیم تا اطلاعات بیشتری در مورد تلاشهای تحقیقاتی پشت برخی از اعلانهای هیجانانگیز در I/O امسال فاش کنیم.

پالم 2

نسل بعدی مدل زبان بزرگ (LLM)، PaLM 2، بر اساس پیشرفتهایی در مقیاسبندی بهینه محاسباتی، تنظیم دقیق دستورالعملهای مقیاسشده و ترکیب دادههای بهبودیافته ساخته شده است. با تنظیم دقیق و تنظیم دستورالعمل مدل برای اهداف مختلف، ما توانستهایم قابلیتهای پیشرفته را در بیش از 25 محصول و ویژگی Google ادغام کنیم، جایی که قبلاً به اطلاعرسانی، کمک و خوشحالی کاربران کمک میکند. مثلا:

- Bard یک آزمایش اولیه است که به شما امکان می دهد با هوش مصنوعی مولد همکاری کنید و به افزایش بهره وری، تسریع ایده ها و تقویت حس کنجکاوی کمک می کند. این بر اساس پیشرفتها در کارایی یادگیری عمیق است و از یادگیری تقویتی از بازخورد انسانی برای ارائه پاسخهای مرتبطتر و افزایش توانایی مدل برای پیروی از دستورالعملها استفاده میکند. Bard اکنون در 180 کشور در دسترس است، جایی که کاربران میتوانند با آن به زبانهای انگلیسی، ژاپنی و کرهای تعامل داشته باشند و به لطف قابلیتهای چند زبانه ارائه شده توسط PalM 2، پشتیبانی از 40 زبان به زودی ارائه میشود.

- با استفاده از «تجربه مولد جستجو»، کارهای بیشتری را از جستجو حذف میکنیم، بنابراین میتوانید موضوعی را سریعتر درک کنید، دیدگاهها و بینشهای جدید را کشف کنید و کارها را راحتتر انجام دهید. به عنوان بخشی از این آزمایش، یک عکس فوری از اطلاعات کلیدی مبتنی بر هوش مصنوعی را میبینید که باید در نظر بگیرید، همراه با پیوندهایی برای بررسی عمیقتر.

- MakerSuite یک محیط نمونهسازی با استفاده آسان برای PaLM API است که توسط PalM 2 پشتیبانی میشود. در واقع، تعامل داخلی کاربر با نمونههای اولیه MakerSuite توسعه خود مدل PaLM 2 را تسریع کرد. MakerSuite از تحقیقات متمرکز بر ابزارهای تحریک کننده یا ابزارهایی که به صراحت برای سفارشی سازی و کنترل LLM طراحی شده اند، رشد کرده است. این خط از تحقیقات شامل PromptMaker (پیش ساز MakerSuite) و AI Chains و PromptChainer (یکی از اولین تلاش های تحقیقاتی که سودمندی زنجیره LLM را نشان می دهد) است.

- Project Tailwind همچنین از نمونه های اولیه تحقیقاتی MakerSuite برای توسعه ویژگی هایی برای کمک به نویسندگان و محققان برای کشف ایده ها و بهبود نثر خود استفاده کرد. اولین نمونه نوت بوک هوش مصنوعی آن از PalM 2 استفاده کرد تا به کاربران اجازه دهد سوالاتی را از مدل بر اساس اسنادی که تعریف می کنند بپرسند.

- Med-PaLM 2 پیشرفته ترین LLM پزشکی ما است که بر روی PalM 2 ساخته شده است. Med-PaLM 2 عملکرد 86.5 درصدی را در سؤالات سبک امتحان مجوز پزشکی ایالات متحده به دست آورد که پتانسیل هیجان انگیز آن را برای سلامتی نشان می دهد. ما اکنون در حال بررسی قابلیت های چندوجهی برای سنتز ورودی هایی مانند اشعه ایکس هستیم.

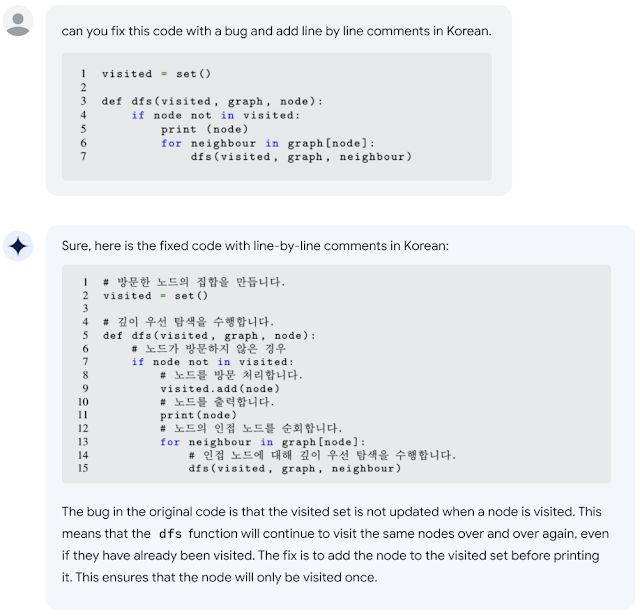

- Codey نسخه ای از PaLM 2 است که روی کد منبع به خوبی تنظیم شده است تا به عنوان دستیار توسعه دهنده عمل کند. از طیف گسترده ای از ویژگی های کد هوش مصنوعی، از جمله تکمیل کد، توضیح کد، رفع اشکال، انتقال کد منبع، توضیحات خطا و موارد دیگر پشتیبانی می کند. Codey از طریق برنامه آزمایشگر مورد اعتماد ما از طریق IDEها (Colab، Android Studio، Duet AI for Cloud، Firebase) و از طریق یک API 3P در دسترس است.

شاید حتی برای توسعه دهندگان هیجان انگیزتر باشد، ما API و MakerSuite PalM را باز کرده ایم تا فرصت هایی را برای جامعه برای نوآوری با استفاده از این فناوری پیشگامانه فراهم کنیم.

|

| PALM 2 دارای قابلیتهای کدگذاری پیشرفتهای است که به آن امکان میدهد خطاهای کد را پیدا کند و به زبانهای مختلف پیشنهاد دهد. |

تصویر

خانواده ایمیجن ما از مدلهای تولید و ویرایش تصویر مبتنی بر پیشرفتها در مدلهای بزرگ زبان مبتنی بر Transformer و مدلهای انتشار است. این خانواده از مدلها در چندین محصول Google گنجانده شدهاند، از جمله:

- تولید تصویر در اسلایدهای Google و تصویر زمینه هوش مصنوعی مولد اندروید توسط ویژگیهای تولید متن به تصویر ما پشتیبانی میشود.

- هوش مصنوعی Vertex Google Cloud تولید تصویر، ویرایش تصویر، ارتقاء تصویر و تنظیم دقیق را برای کمک به مشتریان سازمانی برای برآوردن نیازهای تجاری خود فعال می کند.

- I/O Flip، برداشتی دیجیتال از یک بازی کارتی کلاسیک، دارای طلسم های توسعه دهندگان گوگل بر روی کارت هایی است که کاملاً با هوش مصنوعی تولید شده اند. این بازی یک تکنیک تنظیم دقیق به نام DreamBooth را برای تطبیق مدل های تولید تصویر از پیش آموزش دیده به نمایش گذاشت. با استفاده از تعداد انگشت شماری تصویر به عنوان ورودی برای تنظیم دقیق، به کاربران اجازه می دهد تصاویر شخصی سازی شده را در چند دقیقه تولید کنند. با DreamBooth، کاربران میتوانند یک سوژه را در صحنهها، ژستها، نماها و شرایط نوری مختلف که در تصاویر مرجع ظاهر نمیشوند ترکیب کنند.

I/O Flip عرشه های کارت سفارشی را ارائه می دهد که با استفاده از DreamBooth طراحی شده اند.

فناکی

Phenaki، مدل تولید متن به ویدئو مبتنی بر ترانسفورماتور گوگل در پیش نمایش I/O نمایش داده شد. Phenaki مدلی است که میتواند ویدئوهای واقعی را از توالیهای متنی با استفاده از دو جزء اصلی ترکیب کند: یک مدل رمزگذار-رمزگشا که فیلمها را به جاسازیهای گسسته فشرده میکند و یک مدل ترانسفورماتور که جاسازیهای متن را به نشانههای ویدئویی ترجمه میکند.

|

|

ARCore و Scene Semantic API

در میان ویژگیهای جدید ARCore که توسط تیم AR در I/O اعلام شده است، Scene Semantic API میتواند معنای پیکسلی را در یک صحنه در فضای باز تشخیص دهد. این به کاربران کمک می کند تا تجربیات AR سفارشی را بر اساس ویژگی های منطقه اطراف ایجاد کنند. این API با استفاده از مدل تقسیمبندی معنایی در فضای باز، از کارهای اخیر ما در مورد معماری DeepLab و مجموعه دادههای درک صحنههای بیرونی خودمحورانه استفاده میکند. آخرین نسخه ARCore همچنین شامل یک مدل عمق تک چشمی بهبود یافته است که دقت بالاتری را در صحنه های خارج از منزل ارائه می دهد.

|

| Scene Semantics API از مدل تقسیمبندی معنایی مبتنی بر DeepLab برای ارائه برچسبهای دقیق پیکسلی در یک صحنه در فضای باز استفاده میکند. |

صدای جیر جیر

Chirp خانواده پیشرفتهترین مدلهای گفتار جهانی Google است که با ۱۲ میلیون ساعت گفتار آموزش دیده تا تشخیص خودکار گفتار (ASR) را برای بیش از ۱۰۰ زبان فعال کند. این مدلها میتوانند ASR را بر روی زبانهای فاقد منابع، مانند آمهری، سبوانو، و آسامی، علاوه بر زبانهای رایج مانند انگلیسی و ماندارین انجام دهند. Chirp میتواند با استفاده از یادگیری خود نظارتی روی مجموعه دادههای چندزبانه بدون برچسب با تنظیم دقیق روی مجموعه کوچکتری از دادههای برچسبگذاری شده، چنین طیف گستردهای از زبانها را پوشش دهد. Chirp اکنون در Google Cloud Speech-to-Text API در دسترس است و به کاربران این امکان را می دهد تا از طریق یک رابط کاربری ساده استنتاج مدل را انجام دهند. می توانید با Chirp از اینجا شروع کنید.

MusicLM

در I/O، MusicLM را راهاندازی کردیم، یک مدل تبدیل متن به موسیقی که 20 ثانیه موسیقی را از یک پیام متنی تولید میکند. میتوانید خودتان آن را در AI Test Kitchen امتحان کنید، یا آن را در طول پیش نمایش I/O، که در آن نوازنده الکترونیک و آهنگساز Dan Deacon از MusicLM در اجرای خود استفاده کرد، مشاهده کنید.

MusicLM که متشکل از مدلهایی است که توسط AudioLM و MuLAN پشتیبانی میشوند، میتوانند موسیقی (از متن، زمزمه، تصاویر یا ویدیو) و همراهیهای موسیقی تا آواز بسازند. AudioLM صدایی با کیفیت بالا با ثبات طولانی مدت تولید می کند. این صدا را به دنباله ای از نشانه های مجزا نگاشت می کند و تولید صدا را به عنوان یک کار مدل سازی زبان ارائه می کند. برای ترکیب خروجیهای طولانیتر بهطور مؤثر، از یک رویکرد جدید به نام SoundStorm استفاده کرد.

دوبله مترجم جهانی

تلاشهای ما برای دوبله دهها فناوری ML را برای ترجمه طیف کامل محتوای ویدیویی به کار میبرد و باعث میشود که ویدیوها برای مخاطبان در سراسر جهان قابل دسترسی باشند. این فناوریها برای دوبله کردن ویدیوها در محصولات و انواع محتوا، از جمله محتوای آموزشی، کمپینهای تبلیغاتی، و محتوای سازنده، استفاده شدهاند. ما از فناوری یادگیری عمیق برای دستیابی به حفظ صدا و تطبیق لب و فعال کردن ترجمه ویدیویی با کیفیت بالا استفاده می کنیم. ما این محصول را به گونهای ساختهایم که شامل بررسیهای انسانی برای کیفیت، بررسیهای ایمنی برای کمک به جلوگیری از سوء استفاده میشود، و آن را فقط برای شرکای مجاز در دسترس قرار میدهیم.

هوش مصنوعی برای منافع اجتماعی جهانی

ما از فناوریهای هوش مصنوعی خود برای حل برخی از بزرگترین چالشهای جهانی مانند کاهش تغییرات آب و هوا، سازگاری با سیاره در حال گرم شدن و بهبود سلامت و رفاه انسان استفاده میکنیم. مثلا:

- مهندسان ترافیک از توصیههای چراغ سبز ما برای کاهش ترافیک توقف و حرکت در تقاطعها و بهبود جریان ترافیک در شهرهای بنگلور تا ریودوژانیرو و هامبورگ استفاده میکنند. چراغ سبز هر تقاطع را مدلسازی میکند و الگوهای ترافیکی را تجزیه و تحلیل میکند تا توصیههایی ایجاد کند که چراغهای راهنمایی را کارآمدتر میکند – برای مثال، با همگامسازی بهتر زمانبندی بین چراغهای مجاور، یا تنظیم «زمان سبز» برای یک خیابان و جهت معین.

- ما همچنین به عنوان بخشی از تلاشهای خود برای پیشبینی سیلابهای رودخانهای و هشدار به افرادی که قرار است قبل از وقوع فاجعه تحت تأثیر قرار گیرند، پوشش جهانی مرکز سیل را به 80 کشور گسترش دادهایم. تلاشهای ما برای پیشبینی سیل بر مدلهای هیدرولوژیکی مبتنی بر مشاهدات ماهوارهای، پیشبینیهای آبوهوا و اندازهگیریهای درجا تکیه دارد.

فن آوری برای برنامه های کاربردی ML فراگیر و منصفانه

با سرمایهگذاری مداوم خود در فناوریهای هوش مصنوعی، بر توسعه هوش مصنوعی مسئولانه با هدف مفید و تأثیرگذار ساختن مدلها و ابزارهایمان تأکید میکنیم و در عین حال از عدالت، ایمنی و همسویی با اصول هوش مصنوعی خود اطمینان میدهیم. برخی از این تلاش ها در I/O برجسته شدند، از جمله:

- انتشار مجموعه دادههای نمونههای رنگ پوست Monk (MST-E) برای کمک به پزشکان برای به دست آوردن درک عمیقتر از مقیاس MST و آموزش حاشیهنویسهای انسانی برای حاشیهنویسیهای رنگ پوست منسجمتر، جامعتر و معنادارتر. شما می توانید اطلاعات بیشتر در مورد این و سایر پیشرفت ها را در وب سایت ما بخوانید. این یک پیشرفت در نسخه متن باز مقیاس رنگ پوست Monk (MST) است که ما سال گذشته راه اندازی کردیم تا توسعه دهندگان را قادر سازد محصولاتی بسازند که فراگیرتر باشند و کاربران متنوع خود را بهتر نشان دهند.

- یک مسابقه جدید Kaggle (باز تا 10 آگوست) که در آن جامعه ML وظیفه ایجاد مدلی را دارد که می تواند به سرعت و با دقت املای انگشتی زبان اشاره آمریکایی (ASL) را شناسایی کند – که در آن هر حرف از یک کلمه به سرعت در ASL با استفاده از یک واحد املا می شود. دست، به جای استفاده از علائم خاص برای کل کلمات – و آن را به متن نوشتاری ترجمه کنید. درباره مسابقه املای انگشتی Kaggle، که دارای آهنگی از شان فوربس، یک نوازنده ناشنوا و خواننده رپ است، بیشتر بیاموزید. ما همچنین در I/O الگوریتم برنده از قدرت های رقابت سال قبل PopSign را به نمایش گذاشتیم، یک برنامه یادگیری ASL برای والدین کودکان ناشنوا یا کم شنوا که توسط فناوری جورجیا و موسسه فناوری روچستر (RIT) ایجاد شده است.

آینده هوش مصنوعی را با هم بسازیم

الهام بخش بودن بخشی از جامعه ای از افراد با استعداد بسیار است که در توسعه فناوری های پیشرفته، رویکردهای هوش مصنوعی مسئولانه و تجربیات کاربر هیجان انگیز پیشرو هستند. ما در میانه دوره ای از تغییرات باورنکردنی و متحول کننده برای هوش مصنوعی هستیم. منتظر بهروزرسانیهای بیشتر در مورد روشهایی باشید که جامعه تحقیقاتی Google جسورانه مرزهای این فناوریها را کاوش میکند و مسئولانه از آنها برای سود بردن به زندگی مردم در سراسر جهان استفاده میکند. ما امیدواریم که شما به اندازه ما در مورد آینده فناوری های هوش مصنوعی هیجان زده باشید و از شما دعوت می کنیم تا از طریق مراجع، سایت ها و ابزارهایی که در اینجا برجسته کرده ایم، با تیم های ما تعامل داشته باشید.