مدلهای یادگیری عمیق برای کارهای بصری (مثلاً طبقهبندی تصویر) معمولاً با دادههای یک تصویری منفرد آموزش داده میشوند. دامنه (به عنوان مثال، تصاویر طبیعی یا تصاویر تولید شده توسط کامپیوتر). به طور معمول، برنامهای که وظایف بصری را برای چندین دامنه تکمیل میکند، باید چندین مدل را برای هر دامنه جداگانه بسازد، آنها را به طور مستقل آموزش دهد (به این معنی که هیچ دادهای بین دامنهها به اشتراک گذاشته نمیشود)، و سپس در زمان استنتاج، هر مدل دادههای ورودی دامنه خاص را پردازش میکند. با این حال، لایههای اولیه بین این مدلها ویژگیهای مشابهی را ایجاد میکنند، حتی برای دامنههای مختلف، بنابراین میتواند کارآمدتر باشد – کاهش تأخیر و مصرف انرژی، سربار حافظه کمتر برای ذخیره پارامترهای هر مدل – برای آموزش مشترک چندین دامنه، رویکردی که به آن اشاره میشود. یادگیری چند دامنه ای (MDL). علاوه بر این، یک مدل MDL همچنین میتواند از مدلهای تک دامنه بهتر عمل کند انتقال دانش مثبت، زمانی است که آموزش اضافی در یک دامنه عملاً عملکرد دیگری را بهبود می بخشد. مخالف، انتقال دانش منفیبسته به رویکرد و ترکیب خاص دامنه های درگیر، نیز می تواند رخ دهد. در حالی که کار قبلی بر روی MDL اثربخشی یادگیری مشترک وظایف در چندین حوزه را ثابت کرده است، این شامل یک معماری مدل دست ساز است که برای اعمال در کارهای دیگر ناکارآمد است.

در «شبکههای عصبی چند مسیره برای طبقهبندی بصری چند دامنهای روی دستگاه»، یک مدل کلی MDL پیشنهاد میکنیم که میتواند: 1) به دقت بالا به طور کارآمد دست یابد (تعداد پارامترها و FLOPS را کم نگه دارد)، 2) یاد بگیرد که مثبت را افزایش دهد. انتقال دانش در حین کاهش انتقال منفی، و 3) بهینه سازی موثر مدل مشترک در حین رسیدگی به مشکلات مختلف دامنه خاص. به این ترتیب، ما یک رویکرد جستجوی معماری عصبی چند مسیره (MPNAS) برای ساخت یک مدل یکپارچه با معماری شبکه ناهمگن برای دامنههای متعدد پیشنهاد میکنیم. MPNAS رویکرد جستجوی معماری عصبی کارآمد (NAS) را از جستجوی تک مسیری به جستجوی چند مسیری با یافتن یک مسیر بهینه برای هر دامنه به طور مشترک گسترش می دهد. همچنین، ما یک تابع ضرر جدید به نام اولویتبندی دامنه متعادل تطبیقی (ABDP) معرفی میکنیم که با مشکلات خاص دامنه سازگار میشود تا به آموزش کارآمد مدل کمک کند. رویکرد MPNAS حاصل کارآمد و مقیاس پذیر است. مدل حاصل عملکرد را حفظ می کند در حالی که اندازه مدل و FLOPS را به ترتیب 78 و 32 درصد در مقایسه با رویکرد تک دامنه کاهش می دهد.

جستجوی معماری عصبی چند مسیری

برای تشویق انتقال دانش مثبت و جلوگیری از انتقال منفی، راهحلهای سنتی یک مدل MDL میسازند تا دامنهها بیشتر لایههایی را که ویژگیهای مشترک را در سراسر دامنهها یاد میگیرند (که استخراج ویژگی نامیده میشود) به اشتراک بگذارند، سپس چند لایه خاص دامنه را در بالای آن قرار دهند. با این حال، چنین رویکرد همگنی برای استخراج ویژگی نمیتواند حوزههایی با ویژگیهای بسیار متفاوت (مانند اشیاء در تصاویر طبیعی و نقاشیهای هنری) را مدیریت کند. از سوی دیگر، ساخت یک معماری ناهمگن یکپارچه برای هر مدل MDL زمانبر است و به دانش خاص دامنه نیاز دارد.

NAS یک پارادایم قدرتمند برای طراحی خودکار معماری های یادگیری عمیق است. الف را تعریف می کند فضای جستجو، از بلوک های ساختمانی بالقوه مختلفی تشکیل شده است که می تواند بخشی از مدل نهایی باشد. این الگوریتم جستجو بهترین معماری کاندید را از فضای جستجو که بهینه سازی می کند اهداف مدلبه عنوان مثال، دقت طبقه بندی. رویکردهای اخیر NAS (به عنوان مثال، TuNAS) با استفاده از نمونهبرداری از مسیر انتها به انتها، کارایی جستجو را به طور معناداری بهبود بخشیده است، که ما را قادر میسازد NAS را از یک دامنه به MDL مقیاس کنیم.

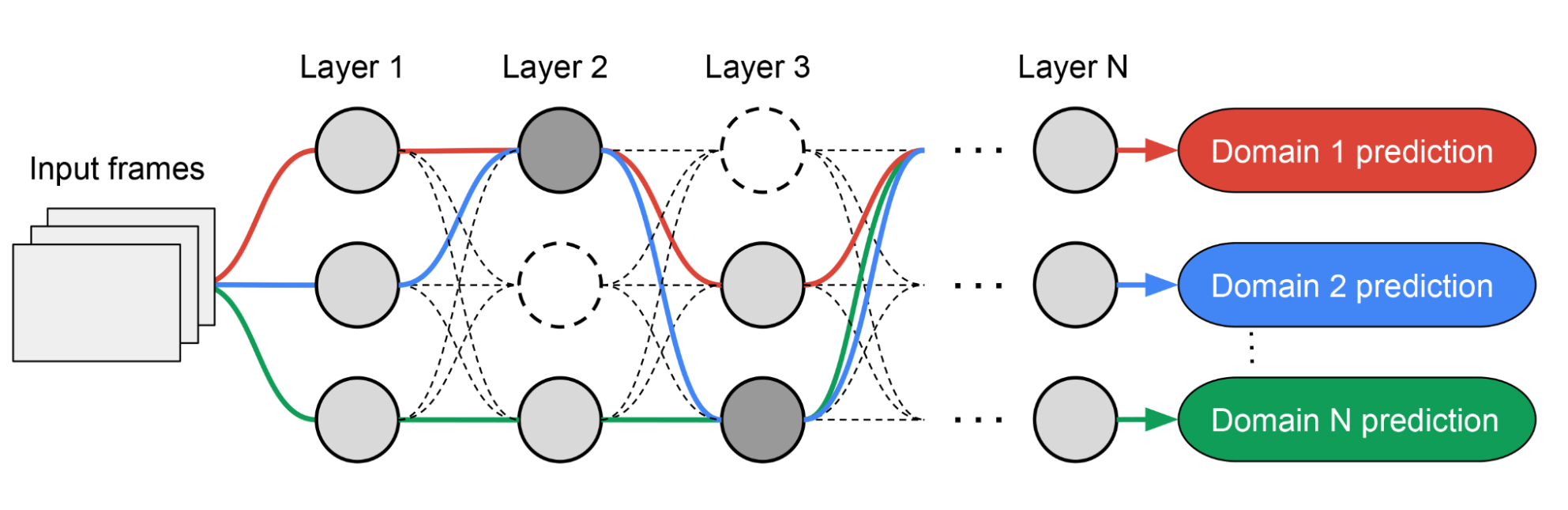

MPNAS با الهام از TuNAS معماری مدل MDL را در دو مرحله ایجاد می کند: جستجو و آموزش. در مرحله جستجو، برای یافتن یک مسیر بهینه برای هر دامنه به طور مشترک، MPNAS یک کنترل کننده یادگیری تقویتی (RL) جداگانه برای هر دامنه ایجاد می کند که از یک مسیر انتها به انتها (از لایه ورودی تا لایه خروجی) از ابر شبکه نمونه برداری می کند. به عنوان مثال، ابرمجموعه تمام زیرشبکه های ممکن بین گره های کاندید تعریف شده توسط فضای جستجو). در طی چندین بار تکرار، همه کنترلکنندههای RL مسیر را برای بهینهسازی پاداشهای RL در همه دامنهها بهروزرسانی میکنند. در پایان مرحله جستجو، برای هر دامنه یک زیرشبکه به دست می آوریم. در نهایت، تمام زیرشبکه ها برای ساختن یک معماری ناهمگن برای مدل MDL، که در زیر نشان داده شده است، ترکیب می شوند.

از آنجایی که زیرشبکه برای هر دامنه به طور مستقل جستجو می شود، بلوک ساختمان در هر لایه می تواند توسط چندین دامنه به اشتراک گذاشته شود (به عنوان مثال، گره های خاکستری تیره)، توسط یک دامنه (یعنی گره های خاکستری روشن) استفاده شود، یا توسط هیچ زیرشبکه ای استفاده نشود. به عنوان مثال، گره های نقطه چین). مسیر هر دامنه همچنین می تواند از هر لایه ای در حین جستجو رد شود. با توجه به اینکه زیرشبکه میتواند آزادانه انتخاب کند که از کدام بلوکها در طول مسیر استفاده کند، بهگونهای که عملکرد را بهینه کند (بهجای اینکه خودسرانه تعیین کند کدام لایهها همگن و کدام یک دامنه خاص هستند)، شبکه خروجی هم ناهمگن و هم کارآمد است.

|

| نمونه معماری جستجو شده توسط MPNAS. مسیرهای چین دار تمام زیرشبکه های ممکن را نشان می دهند. مسیرهای جامد نشان دهنده زیرشبکه های انتخاب شده برای هر دامنه هستند (با رنگ های مختلف برجسته شده اند). گره ها در هر لایه نشان دهنده بلوک های ساختمانی نامزد تعریف شده توسط فضای جستجو هستند. |

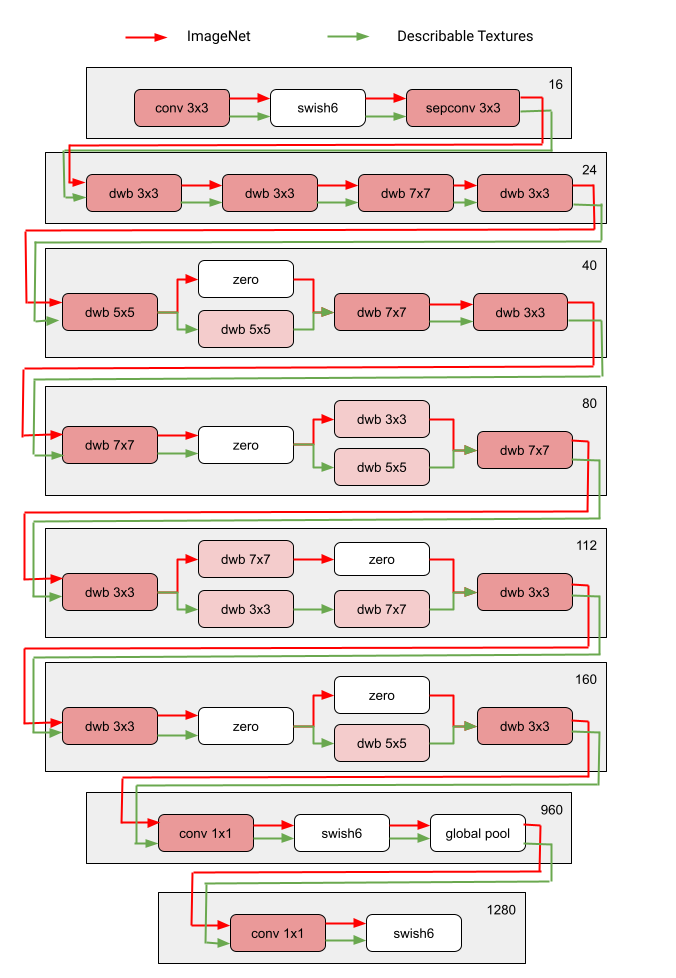

شکل زیر معماری جستجو شده دو حوزه بصری را در بین ده دامنه چالش ویژوال دامنه دهگانه نشان میدهد. می توان مشاهده کرد که زیرشبکه این دو دامنه بسیار مرتبط (یکی قرمز و دیگری سبز) اکثر بلوک های ساختمانی را از مسیرهای همپوشانی خود به اشتراک می گذارند، اما هنوز تفاوت هایی وجود دارد.

|

| بلوک های معماری دو دامنه (ImageNet و بافت های قابل توصیف) در میان ده دامنه چالش ویژوال دامنه دکاتلون. مسیر قرمز و سبز نشان دهنده زیرشبکه از ImageNet و بافت های قابل توصیف، به ترتیب. گره های صورتی تیره نشان دهنده بلوک های مشترک توسط چندین دامنه هستند. گره های صورتی روشن نشان دهنده بلوک های استفاده شده توسط هر مسیر هستند. این مدل بر اساس فضای جستجو مانند MobileNet V3 ساخته شده است. بلوک “dwb” در شکل نشان دهنده بلوک dwbottleneck است. بلوک “صفر” در شکل نشان می دهد که زیرشبکه از آن بلوک عبور می کند. |

در زیر شباهت مسیر بین دامنهها در بین ده دامنه چالش Visual Domain Decathlon را نشان میدهیم. شباهت با امتیاز شباهت جاکارد بین زیرشبکههای هر دامنه اندازهگیری میشود، جایی که بالاتر به معنای شبیهتر بودن مسیرها است. همانطور که انتظار میرود، دامنههایی که شبیهتر هستند، گرههای بیشتری را در مسیرهای تولید شده توسط MPNAS به اشتراک میگذارند که این نیز سیگنالی از انتقال دانش مثبت قوی است. به عنوان مثال، مسیرهای مربوط به دامنه های مشابه (مانند ImageNet، CIFAR-100، و گل VGG، که همگی شامل اشیاء در تصاویر طبیعی هستند) امتیاز بالایی دارند، در حالی که مسیرهای دامنه های غیرمشابه (مانند طبقه بندی عابر پیاده دایملر و تصاویر پویا UCF101، که به ترتیب شامل عابران پیاده در تصاویر خاکستری و فعالیت انسانی در تصاویر رنگی طبیعی می شود) امتیاز پایینی دارند.

|

| ماتریس سردرگمی برای امتیاز شباهت جاکارد بین مسیرهای ده حوزه. مقدار امتیاز از 0 تا 1 متغیر است. مقدار بیشتر نشان می دهد که دو مسیر گره های بیشتری را به اشتراک می گذارند. |

آموزش یک مدل چند دامنه ای ناهمگن

در مرحله دوم، مدل حاصل از MPNAS از ابتدا برای همه دامنه ها آموزش داده می شود. برای این کار لازم است a تعریف شود متحد شده است تابع هدف برای همه دامنه ها برای مدیریت موفقیت آمیز دامنه های مختلف، ما الگوریتمی را طراحی کردیم که در طول فرآیند یادگیری به گونه ای تطبیق می یابد که تلفات در دامنه ها متعادل می شود، به نام اولویت بندی دامنه متعادل تطبیقی (ABDP).

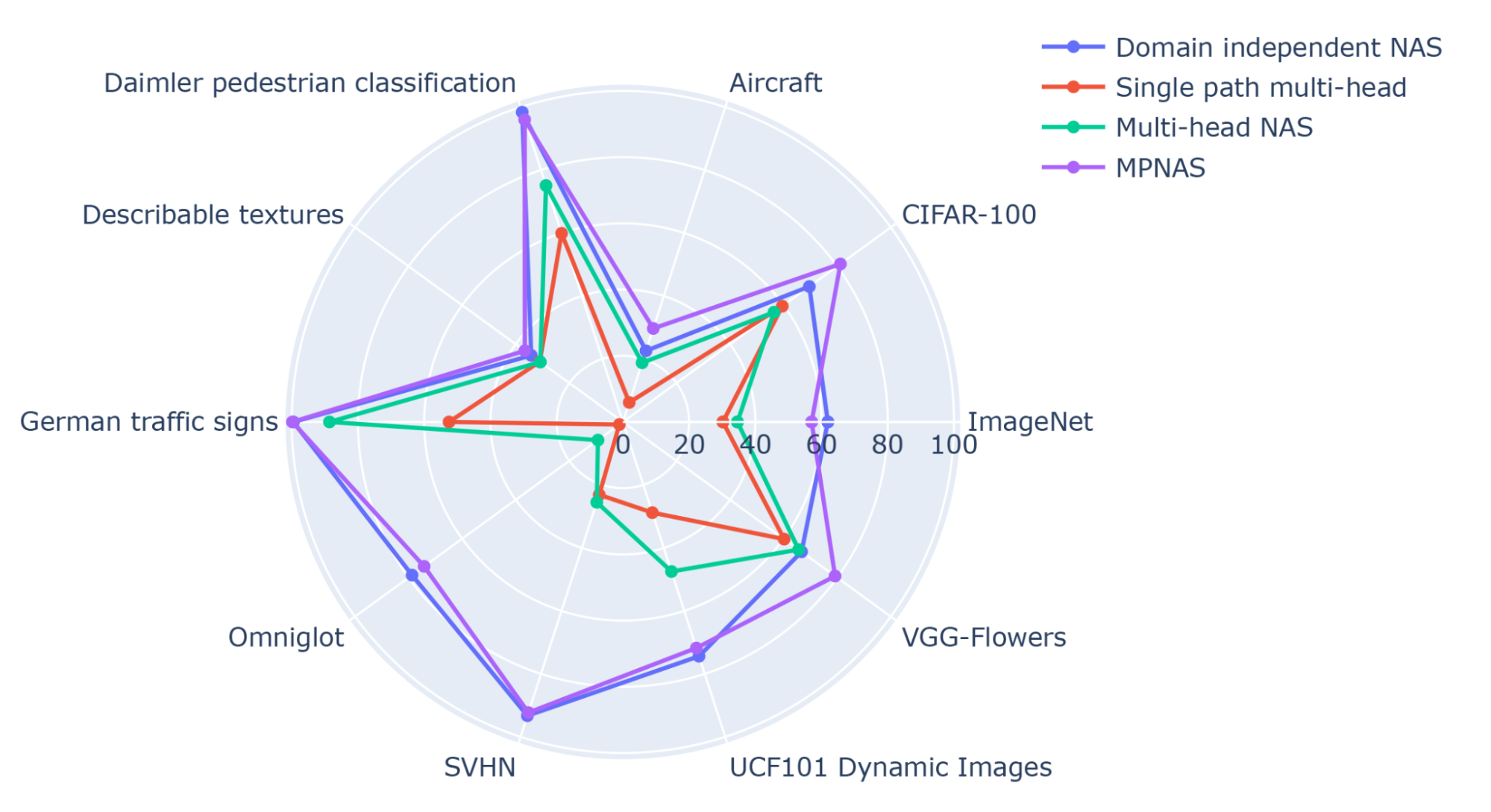

در زیر دقت، اندازه مدل و FLOPS مدل آموزش دیده در تنظیمات مختلف را نشان می دهیم. ما MPNAS را با سه رویکرد دیگر مقایسه می کنیم:

- NAS مستقل از دامنه: جستجو و آموزش مدل برای هر دامنه به صورت جداگانه.

- تک مسیره چند سر: استفاده از یک مدل از پیش آموزش دیده به عنوان ستون فقرات مشترک برای همه دامنه ها با سرهای طبقه بندی مجزا برای هر دامنه.

- NAS چند سر: جستجوی یک معماری ستون فقرات یکپارچه برای همه دامنه ها با سرهای طبقه بندی مجزا برای هر دامنه.

از نتایج، می توانیم آن را مشاهده کنیم NAS مستقل از دامنه نیاز به ساخت بستهای از مدلها برای هر دامنه دارد که در نتیجه یک مدل بزرگ ایجاد میشود. با اينكه تک مسیره چند سر و NAS چند سر می تواند اندازه مدل و FLOPS را به طور قابل توجهی کاهش دهد، و دامنه ها را مجبور به اشتراک گذاری ستون فقرات یکسان کند، انتقال دانش منفی را معرفی می کند و دقت کلی را کاهش می دهد.

| مدل | نسبت تعداد پارامترها | GFLOPS | دقت متوسط Top-1 |

| NAS مستقل از دامنه | 5.7 برابر | 1.08 | 69.9 |

| تک مسیره چند سر | 1.0x | 0.09 | 35.2 |

| NAS چند سر | 0.7x | 0.04 | 45.2 |

| MPNAS | 1.3 برابر | 0.73 | 71.8 |

| تعداد پارامترها، gigaFLOPS و دقت Top-1 (%) مدلهای MDL در مجموعه دادههای Visual Decathlon. همه روشها بر اساس فضای جستجو مانند MobileNetV3 ساخته شدهاند. |

MPNAS می تواند یک مدل کوچک و کارآمد بسازد و در عین حال دقت کلی بالایی را حفظ کند. میانگین دقت MPNAS حتی 1.9٪ بیشتر از آن است NAS مستقل از دامنه رویکرد از آنجایی که مدل انتقال دانش مثبت را امکان پذیر می کند. شکل زیر دقت بالای 1 این رویکردها را در هر دامنه مقایسه می کند.

|

| دقت بالای 1 هر دامنه ویژوال Decathlon. |

ارزیابی ما نشان میدهد که با استفاده از ABDP به عنوان بخشی از مراحل جستجو و آموزش، دقت top-1 از 69.96٪ به 71.78٪ (دلتا: +1.81٪) بهبود یافته است.

|

| دقت برتر برای هر دامنه Visual Decathlon آموزش داده شده توسط MPNAS با و بدون ABDP. |

کار آینده

ما دریافتیم که MPNAS یک راه حل کارآمد برای ایجاد یک شبکه ناهمگن برای رسیدگی به عدم تعادل داده، تنوع دامنه، انتقال منفی، مقیاس پذیری دامنه، و فضای جستجوی بزرگ استراتژی های به اشتراک گذاری پارامتر ممکن در MDL است. با استفاده از یک فضای جستجو مانند MobileNet، مدل به دست آمده نیز سازگار با موبایل است. ما همچنان به گسترش MPNAS برای یادگیری چند کاره برای کارهایی که با الگوریتمهای جستجوی موجود سازگار نیستند ادامه میدهیم و امیدواریم دیگران از MPNAS برای ایجاد یک مدل چند دامنهای یکپارچه استفاده کنند.

سپاسگزاریها

این کار از طریق همکاری چند تیم در سراسر Google امکان پذیر است. مایلیم از مشارکت های جونجی که، جاشوا گریوز، گریس چو، رامین مهران، گابریل بندر، خوهوی جیا، برندان جو، یوکون ژو، لوسیانو سبایز، الک گو، اندرو هاوارد، جف گیلبرت، پیمان میلانفر و مینگ قدردانی کنیم. هسوان یانگ.