@نورونیNeuroSYS

آژانس توسعه نرم افزار با تمرکز قوی بر یادگیری ماشین و هوش مصنوعی

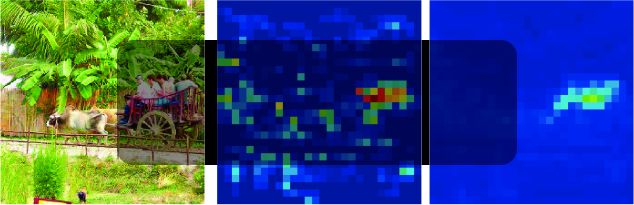

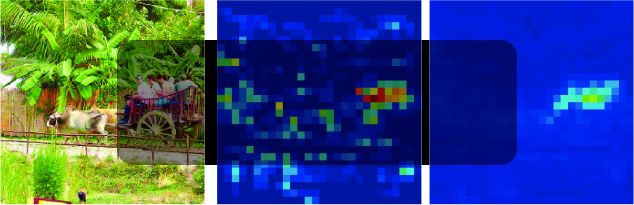

در مقاله قبلی ما ، ما نشان دادیم که شبکه های عصبی در برابر حملات خصمانه دقیق ، یعنی حملات مبتنی بر تغییرات جزئی ورودی ، آسیب پذیر هستند.

در حالی که این اغتشاشات غالباً برای یک ناظر انسانی قابل مشاهده نیستند یا به عنوان سر و صدایی قابل درک نیستند ، اما حتی می توانند موفق ترین سیستم های مبتنی بر شبکه عصبی پیشرفته را فریب دهند. بنابراین ، داشتن توانایی دفاع در برابر چنین حملاتی ، از اهمیت ویژه ای برخوردار است ، به ویژه در محیط های دارای ایمنی.

طی سالهای گذشته تکنیک های مختلفی برای دستیابی به این هدف ارائه شده است ، از جمله شامل: آموزش خصومت ، پردازش یا تغییر شکل تصویر و خنثی سازی ویژگی ها نیست.

محبوب ترین استراتژی دفاعی آموزش خصومت است. در این روش ، تصاویر با رویکردی انتخاب شده مورد حمله خصمانه قرار می گیرند و مثالهای آشفته در طول دوره آموزش به مدل معرفی می شوند تا بتواند آنها را طبقه بندی صحیح کند. [1,2].

گروه دیگری از روش ها شامل پیش پردازش تصویر است. از آنجا که اغتشاشات غالباً به عنوان نویز برای مشاهده گر انسانی تلقی می شود ، چندین رویکرد مبتنی بر تبدیل یا پردازش تصاویر ورودی قبل از اینکه به شبکه عصبی تغذیه شوند ، دارای …